CPO 共封裝光學完整解析:用光擴展下一代互連技術

CPO 共封裝光學完整解析:用光擴展下一代互連技術

本文翻譯自 SemiAnalysis 的深度報告,涵蓋 Scale-out 與 Scale-up CPO、CPO TCO 與功耗預算、DSP 收發器 vs LPO vs NPO vs CPO、TSMC COUPE、MZM vs MRM vs EAM 調變器深度分析、CPO 專注公司與 CPO 供應鏈。

共封裝光學(Co-Packaged Optics,CPO)長期以來一直承諾將改變資料中心的連接方式,但該技術花了很長時間才進入市場,真正可部署的產品直到 2025 年才出現。與此同時,可插拔收發器憑藉其相對的成本效益、部署的熟悉度以及基於標準的互操作性,持續跟上網路需求並保持為默認路徑。

然而,AI 工作負載帶來的大量網路需求意味著這次情況不同。AI 網路頻寬路線圖使得互連速度、距離、密度和可靠性需求將很快超過收發器所能提供的範圍。CPO 將為 scale-out 網路帶來一些好處和更多選擇,但它對 scale-up 網路將是核心的。CPO 將成為本十年後半期及以後 scale-up 網路頻寬增長的主要驅動力。

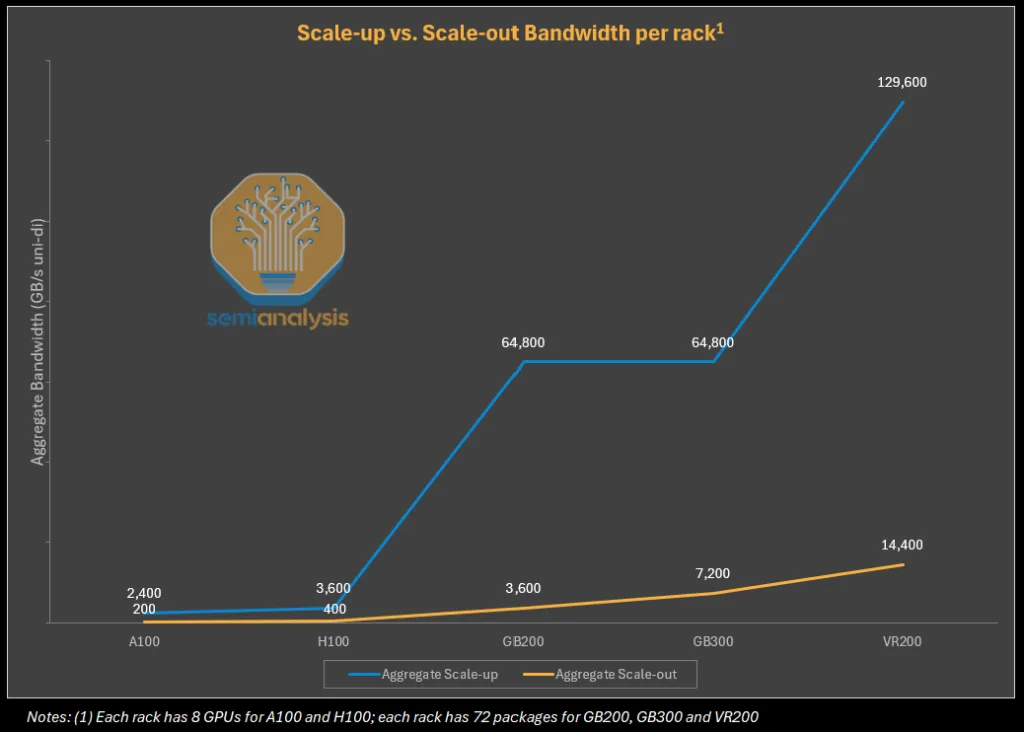

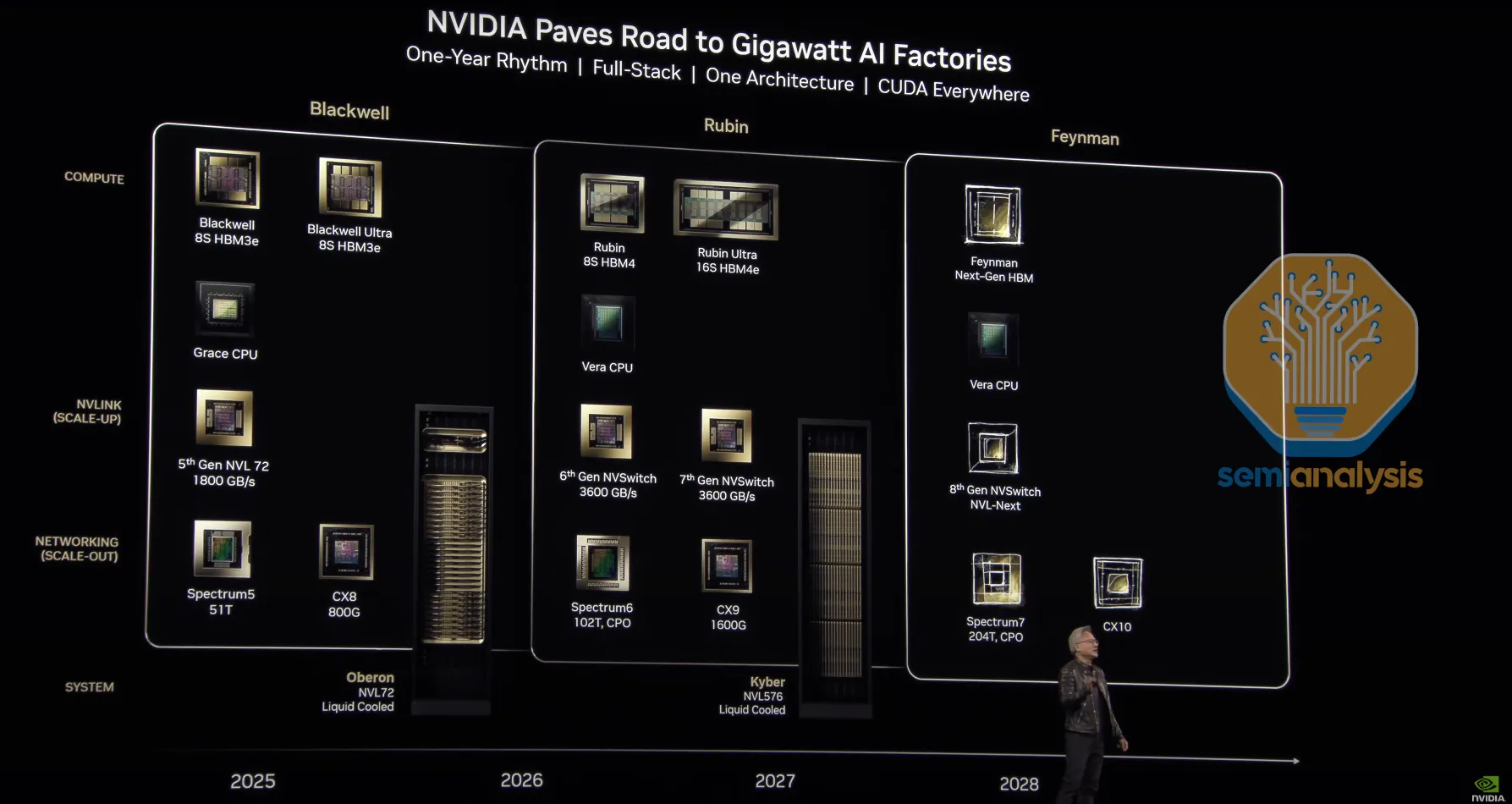

當今基於銅線的 scale-up 解決方案,如 NVLink,每 GPU 提供 7.2 Tbit/s 的巨大頻寬——在 Rubin 代將達到 14.4 Tbit/s——但基於銅線的連接距離最多限制在兩米,這意味著 scale-up 域的世界規模僅限於一到兩個機架。此外,在銅線上擴展頻寬越來越困難。在 Rubin 中,Nvidia 將通過雙向 SerDes 實現每銅線通道頻寬的再次翻倍,但通過開發更快的 SerDes 來在銅線上翻倍頻寬是一個非常具有挑戰性的擴展方向,進展緩慢。CPO 可以提供相同或更好的頻寬密度,並且可以提供額外的頻寬擴展途徑,同時實現更大的 scale-up 域。

理解 CPO 推動力的一個起點是考慮使用收發器進行光學通訊時的許多低效率和權衡。收發器可用於實現更大的連接距離,但網路交換器或計算托盤前面板上收發器插入的籠子通常距離 XPU 或交換器 ASIC 15-30cm。這意味著信號必須首先使用 LR SerDes 在這 15-30cm 的距離上以電方式傳輸,電信號在被轉換為光信號之前由收發器內的數位信號處理器(DSP)恢復和調節。使用 CPO,光引擎則直接放置在 XPU 或交換器 ASIC 旁邊,這意味著可以消除 DSP,並且可以使用更低功耗的 SerDes 將數據從 XPU 移動到光引擎。與 DSP 收發器相比,這可以將傳輸數據所需的能量減少 50% 以上——許多人希望將每比特的能量需求減少多達 80%。

來源:SemiAnalysis

來源:SemiAnalysis

雖然像 Nvidia 和 Broadcom 的 scale-out CPO 解決方案正在獲得更多關注並被終端客戶密切關注,但主要的超大規模雲端公司已經開始規劃他們的 scale-up CPO 策略並向供應商做出承諾。例如,Celestial AI 估計到 2028 年底可能實現 10 億美元的收入運行率——我們認為這主要是由與 Amazon 的 Trainium 4 一起出貨的 CPO scale-up 解決方案驅動的。

CPO 專注公司現在已經遠遠超出論文、試點項目和演示階段,正在做出關鍵的產品決策,如光學端口架構以解決大規模製造問題。Scale-up 的 CPO 現在不是是否和為什麼的問題,而是何時和如何的問題——如何將這些系統推向量產,以及關鍵零件供應鏈公司如雷射製造商何時能夠提高足夠的產能。

本文將深入討論 CPO 的優勢和挑戰、CPO 架構如何運作、當前和未來的 CPO 產品、CPO 專注公司、CPO 相關元件及其各自的供應鏈。本文旨在為從業者、產業分析師、投資者以及所有對互連技術感興趣的人提供指南。

目錄與文章指南

我們將文章分為五個部分——讀者可以專注於最感興趣或最相關的章節。

第一部分:CPO 總持有成本(TCO)分析,我們首先分析採用 CPO 如何改變 scale-out 和 scale-up 網路的總持有成本。我們認為 TCO、可靠性和設備供應商議價能力將是 scale-out 網路採用 CPO 的主要考慮因素。我們將探討 CPO 是否已準備好用於 scale-out 的黃金時段,並觸及迄今為止關於解決方案可靠性的數據,如 Meta 在 ECOC 2025 上展示的 CPO scale-out 交換器研究。

第二部分:CPO 介紹與實施,我們將更深入地了解 CPO 的工作原理。本節將探討市場從銅線到共封裝銅線以及從數位信號處理器(DSP)光學到線性可插拔光學(LPO)再到 CPO 的演進,以及採用 CPO 的推動因素和論點。SerDes 擴展限制和 Wide I/O 作為 SerDes 的替代方案——特別是與 CPO 結合使用時——也將被討論。

第三部分:將 CPO 推向市場,我們將描述使 CPO 獲得牽引力並進入市場的關鍵技術。我們首先討論主機和光引擎封裝,並詳細解釋 TSMC COUPE 以及為什麼它正在成為首選的整合選項。光纖附著單元(FAU)、光纖耦合以及邊緣耦合與光柵耦合器將被徹底解釋。我們將涵蓋調變器類型,如馬赫-曾德調變器(MZM)、微環調變器(MRM)和電吸收調變器(EAM)。本節將以解釋 CPO 被採用的核心原因結束——CPO 擴展頻寬的多種不同途徑:更多附著的光纖、使用波長分割多工(WDM)和更高階的調變。

第四部分:當今和未來的 CPO 產品,我們將分析當今市場上可用的 CPO 產品及其相關供應鏈。我們將從 Nvidia 和 Broadcom 的解決方案開始,然後討論主要的 CPO 公司。我們涵蓋 Ayar Labs、Nubis、Celestial AI、Lightmatter、Xscape Photonics、Ranovus 和 Scintil,詳細描述每家供應商的解決方案,並對每家公司方法的重要優缺點進行評估。

最後,第五部分:Nvidia 的 CPO 供應鏈,我們將通過詳細描述 Nvidia CPO 生態系統的供應鏈來結束本報告,指出雷射光源、ELS 模組、FAU、FAU 對準工具、FAU 組裝、Shuffle Box、MPO 連接器、MT 套圈、光纖和 E/O 測試的關鍵供應商。

第一部分:CPO 總持有成本(TCO)分析

今年早些時候在 Nvidia 的 GTC 2025 上,最受期待的話題之一是 Jensen 宣布公司首批支援 CPO 的 scale-out 網路交換器。值得注意的是,對於 scale-up,Nvidia 仍然在推進銅線並竭盡全力避免轉向光學,即使到 2027 年和 2028 年也是如此。

讓我們從檢視這些新的 CPO 交換器的總持有成本開始討論,分析 scale-out CPO 可以提供的成本和功耗節省。

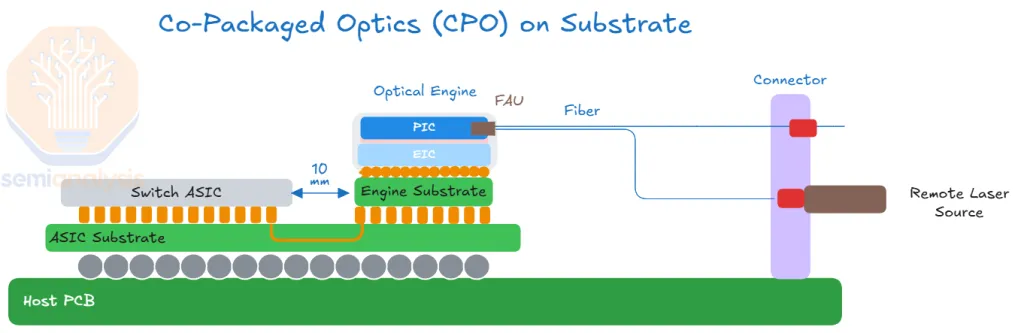

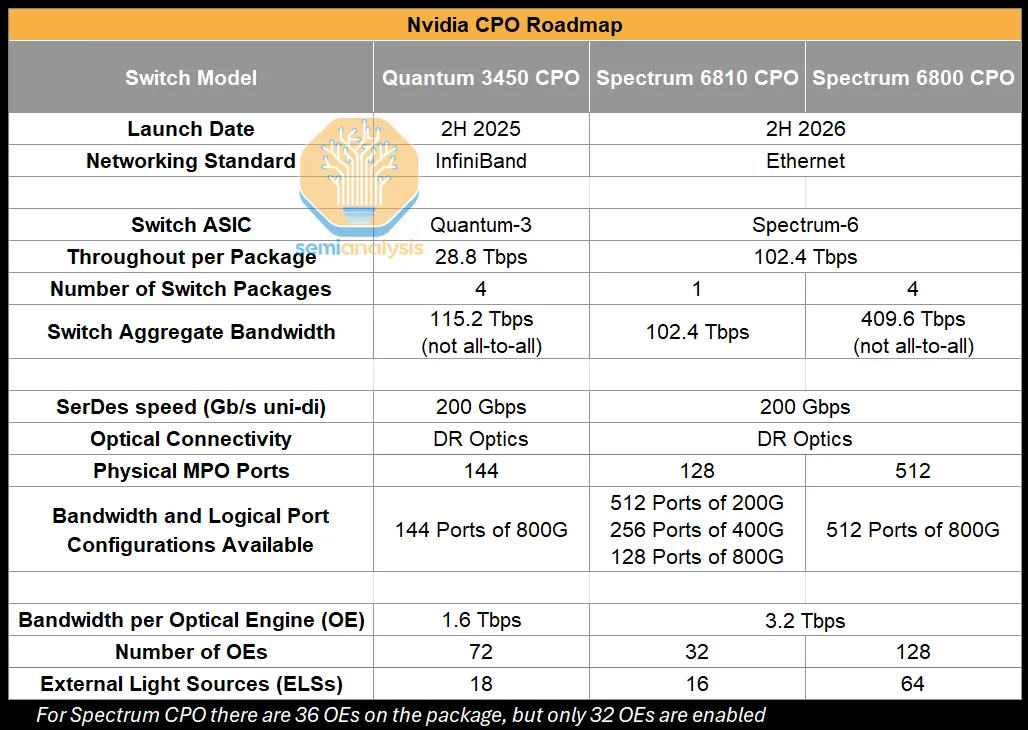

Nvidia 的 GTC 2025 主題演講宣布了三款不同的 CPO scale-out 交換器,使用兩種不同的支援 CPO 的交換器 ASIC。雖然有 TCO、功耗和部署速度的優勢——但它們不足以讓客戶一頭扎進一個完全不同的部署模式,我們預計第一波 CPO scale-out 交換器的採用將有限。讓我們看看為什麼。

來源:SemiAnalysis

來源:SemiAnalysis

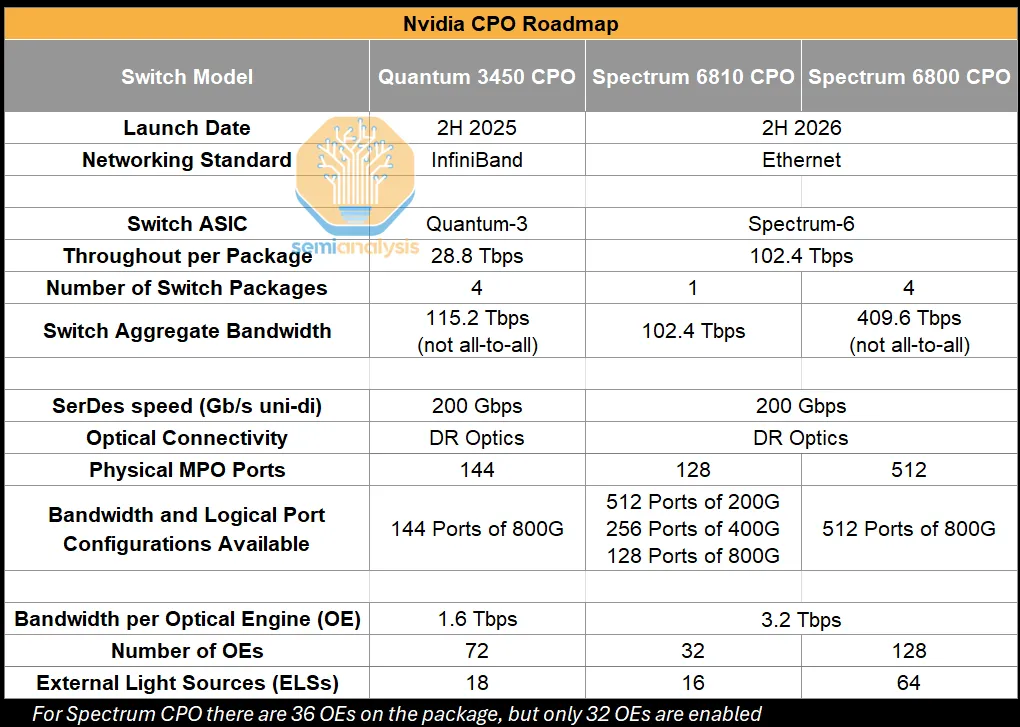

典型的 AI 叢集網路配置和 TCO

典型的 AI 叢集有三個主要的網路架構:後端、前端和帶外管理架構。使用最頻繁且技術要求最高的網路架構是後端架構。後端架構用於 GPU 之間的 scale-out 通訊,以便在平行化訓練和推理的集體操作中相互通訊和交換數據。後端網路通常使用 InfiniBand 或 Ethernet 協議。

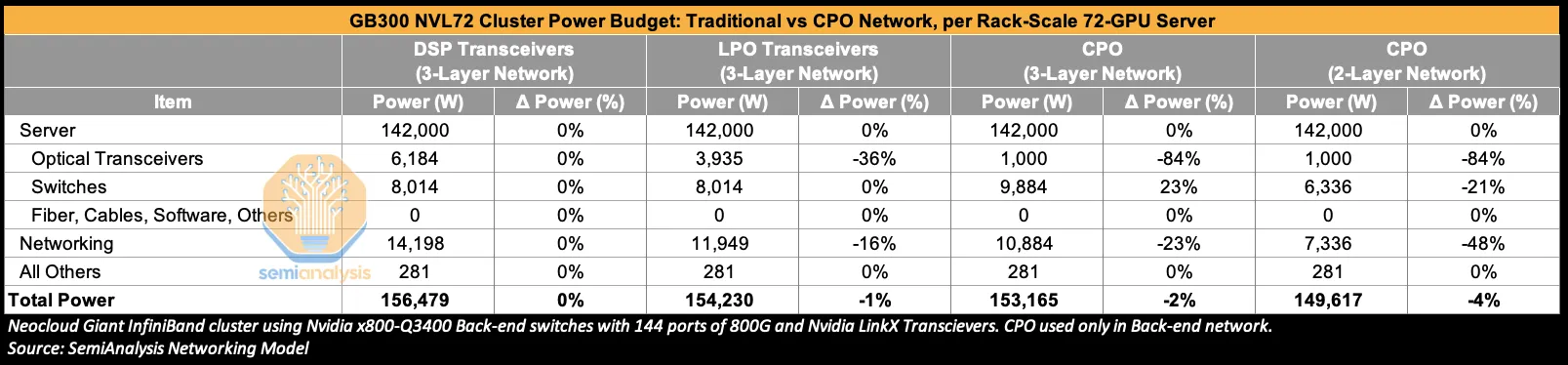

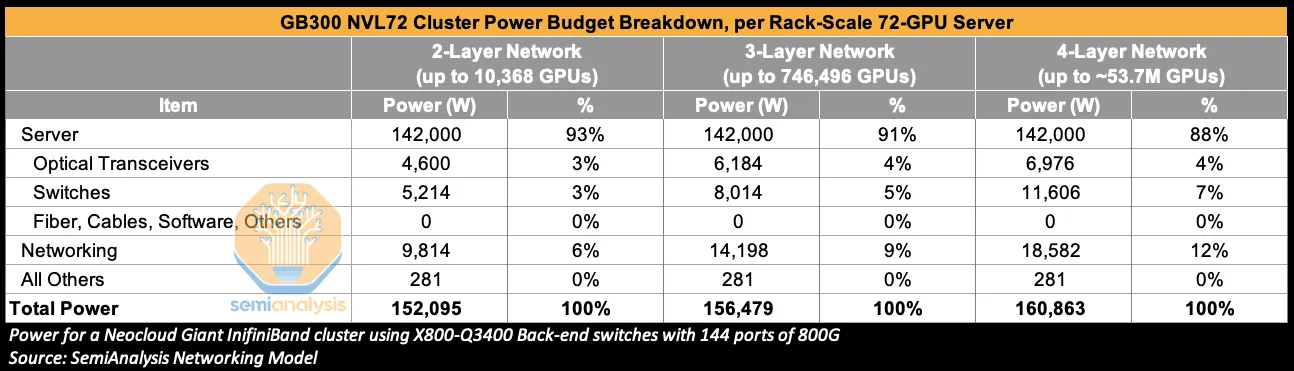

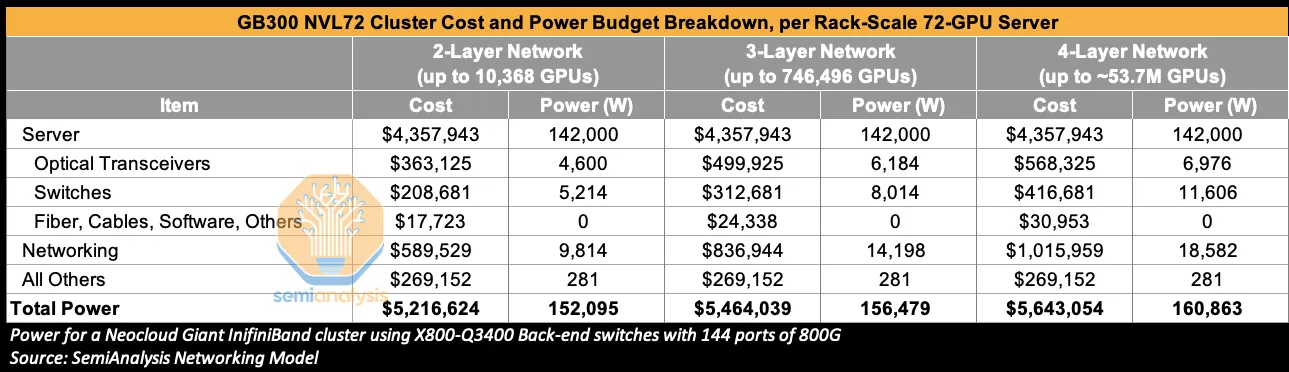

由於其要求苛刻的特性,後端網路佔總網路成本和功耗的主要份額,對於使用 Nvidia X800-Q3400 後端交換器在 InfiniBand 上部署的 3 層 GB300 NVL72 叢集,分別佔網路成本的 85% 和網路功耗的 86%。基於 CPO 的交換器和網路解決方案可用於後端和前端網路,但我們認為目前部署的重點將放在後端網路上。

放大來看——網路成本是 AI 叢集總成本中僅次於 AI 伺服器本身的第二大組成部分。在具有 3 層 InfiniBand 網路的 GB300 NVL72 叢集中,這佔總叢集成本的 15%,對於 4 層網路則達到總叢集成本的 18%。光學收發器是這一成本的重要組成部分,在使用相對較貴的 Nvidia LinkX 收發器時,對於 3 層網路佔網路成本的 60%。它們還消耗 3 層網路總網路功耗的 45%。

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

AI 叢集中 GPU 的數量越多,就越有可能需要更多的網路層。從兩層網路過渡到三層網路及更高層意味著更高的成本和更大的功耗預算。CPO 既可以在保持層數不變的情況下幫助降低功耗和成本,也可以通過擴大可以在給定層數網路上連接的 GPU 數量來降低總功耗和成本需求。

CPO Scale-out 功耗預算

今年早些時候,在 GTC 2025 上,Nvidia CEO 黃仁勳強調了僅收發器的巨大功耗作為 CPO 的關鍵推動因素。使用上表中的一些每機架功耗預算,一個在三層網路上的 200,000 GB300 NVL72(每機架 72 個 GPU 封裝和 144 個計算晶片)GPU 叢集將消耗 435 MW 的關鍵 IT 功率,其中僅光學收發器就消耗 17 MW。顯然,通過消除大部分收發器內容可以節省大量功率。

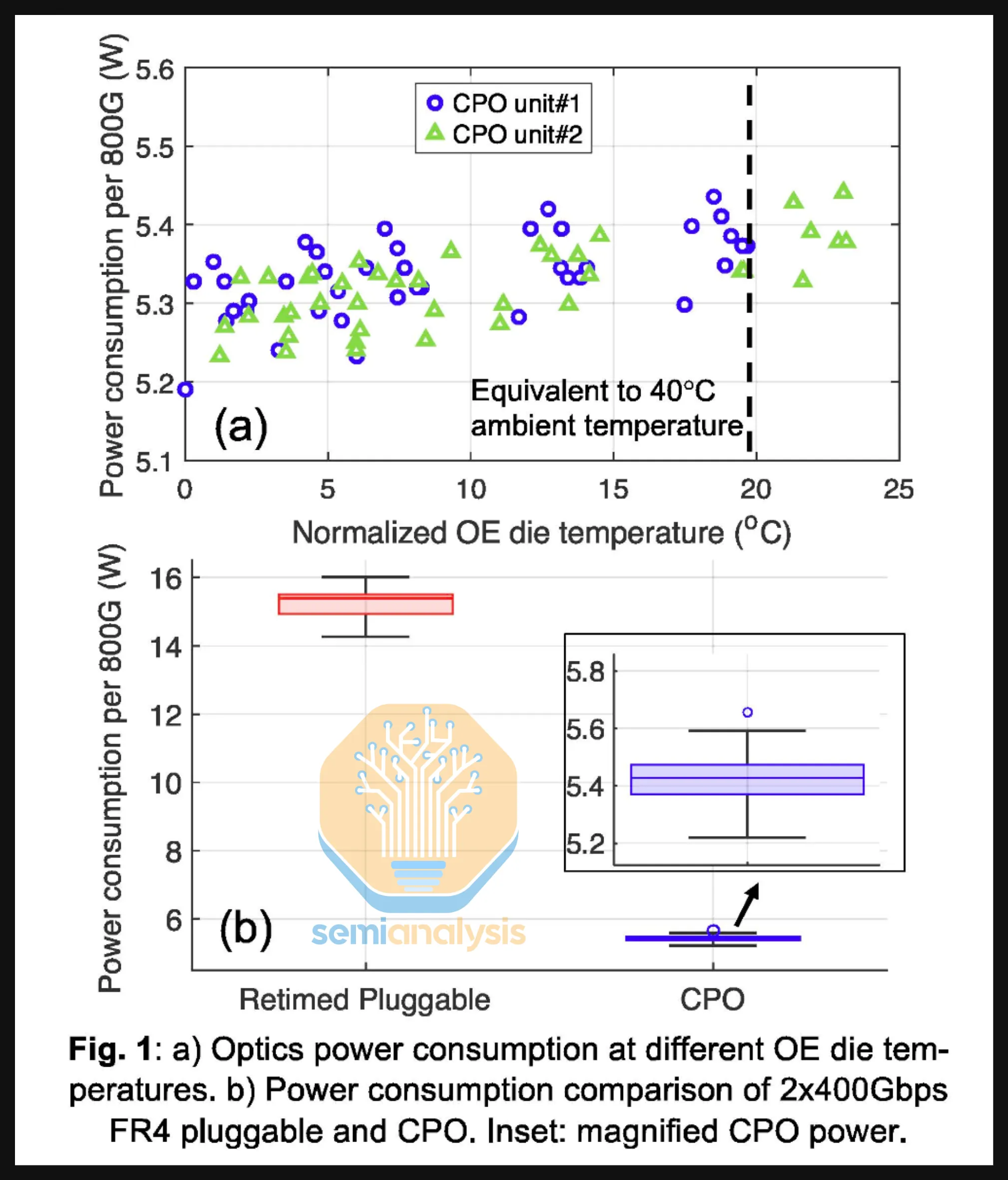

這可以通過比較僅一個 800G DSP 收發器使用的功率與 CPO 系統內光引擎和雷射光源消耗的功率(每 800G 頻寬)來輕鬆看出。雖然一個 800G DR4 光學收發器消耗約 16-17W,但我們估計 Nvidia Q3450 CPO 交換器中使用的光引擎加上外部雷射光源每 800G 頻寬消耗約 4-5W,功率減少 73%。

這些數據與 Meta 在 ECOC 2025 發表和展示的論文中呈現的數據非常接近。在這份報告中,Meta 展示了一個 800G 2xFR4 可插拔收發器消耗約 15W,而 Broadcom Bailly 51.2T CPO 交換器內的光引擎和雷射光源每 800G 頻寬消耗約 5.4W,功率節省 65%。

來源:Meta

來源:Meta

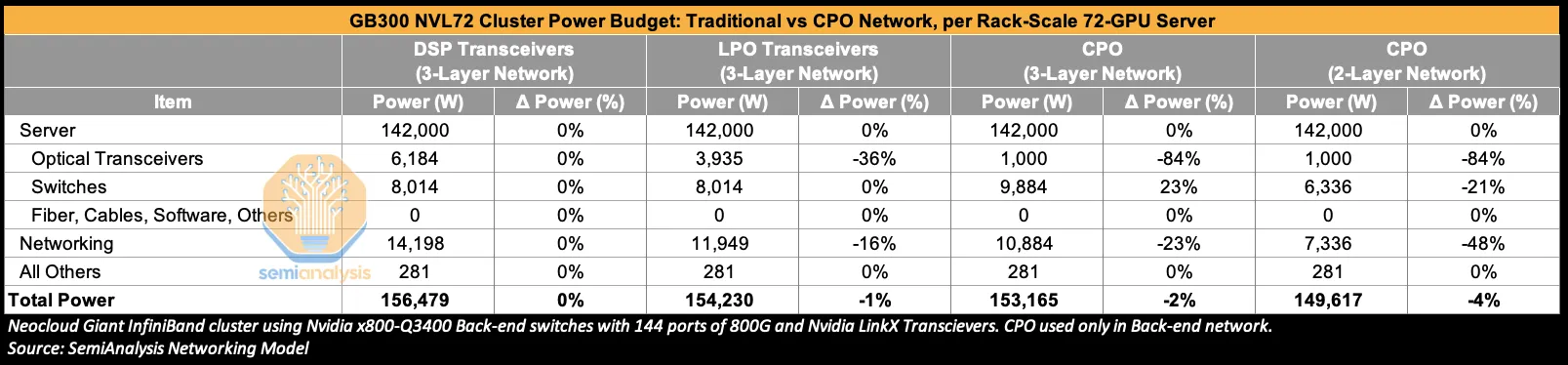

讓我們將這一分析擴展到叢集層面。轉向建立在三層網路上的 GB300 NVL72 叢集,我們看到從 DSP 收發器轉向在後端網路中使用 LPO 收發器可以將總收發器功耗減少 36%,將總網路功耗減少 16%。完全轉向 CPO 相對於 DSP 光學可以產生更大的節省——將收發器功耗削減 84%——儘管這部分功率節省被向交換器添加光引擎(OE)和外部光源(ELS)所抵消,這些現在總共消耗多 23% 的功率。

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

使用 Nvidia 的 CPO scale-out 交換器隱含地意味著默認使用高基數網路,儘管這對終端用戶來說是「抽象」的,因為 shuffle 發生在交換器盒內,而不是在使用高基數非 CPO 交換器時通過配線架或章魚電纜在交換器盒外。相反,這些 Nvidia CPO 交換器呈現為具有非常高的端口數量——例如 Quantum 3450 提供 144 個 800G 端口,Spectrum 6800 提供 512 個 800G 端口。這種高端口數量可能允許客戶將網路從三層扁平化為兩層網路,也節省了客戶部署 shuffle box 和配線架或笨重章魚電纜的麻煩,可能是一個關鍵賣點。在兩層的情況下,收發器功耗減少 84%,交換器功耗下降 21%,與傳統 DSP 收發器相比,總網路功耗可減少 48%。

到目前為止討論的功率節省——三層 CPO 網路為 23%,降到兩層 CPO 網路為 48%——聽起來很棒,但問題是對於三層網路,網路一開始只佔總叢集功率的 9%。所以,最終切換到 CPO 的影響至少對於 scale-out 網路來說被大大稀釋了。切換到三層網路使用 CPO 將網路功耗降低 23%,但只提供 2% 的總叢集功率節省。轉向兩層網路提供 48% 更低的網路成本,但只有 4% 的總叢集功率節省。

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

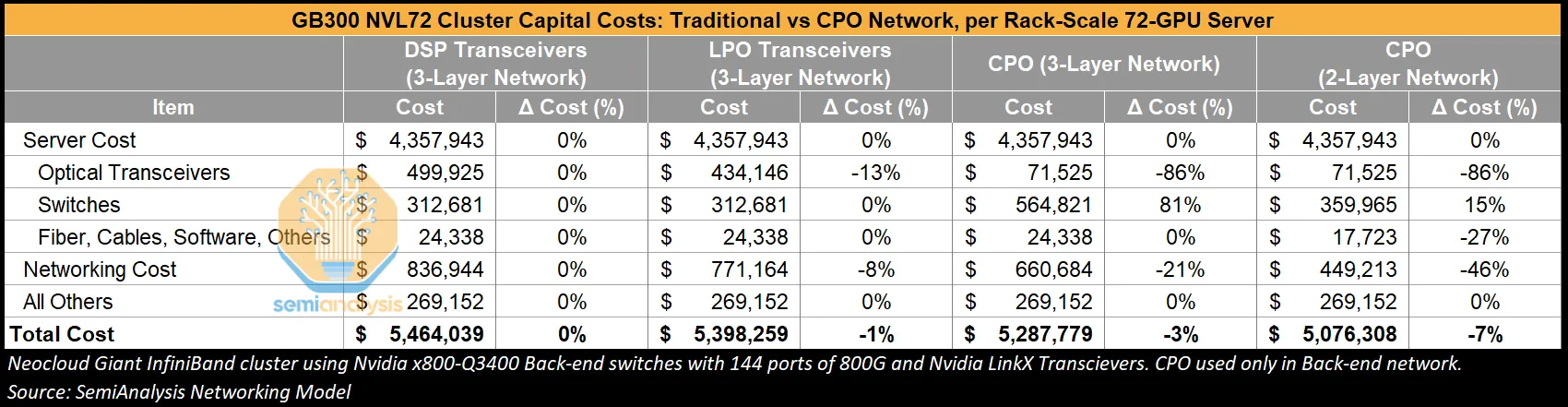

查看總叢集資本成本時,情況類似。

CPO Scale-out 總持有成本(TCO)

讓我們簡要放大一些比較收發器和 CPO 解決方案時的成本細節。第一款 Nvidia CPO 交換器 Quantum X800-Q3450 CPO 將使用 72 個光引擎,每個以 1.6Tbit/s 運行;較新版本的 Quantum CPO 交換器可能會過渡到 36 個光引擎,每個 3.2Tbit/s,每個單位成本約 1,000 美元(包括 FAU),這轉化為每系統 36k 美元的 OE 總成本。

為了將這放在角度來看,考慮如果使用傳統光學收發器模組的總成本。非 CPO X800-Q3400 具有 72 個 OSFP 籠,使用 1.6T 雙端口收發器提供 144 個 800G 端口。假設通用 1.6T DR8 收發器的成本為 1,000 美元,填滿此交換器的總收發器成本將達到 72,000 美元,這是 CPO 交換器所需的光引擎和 ELS 估計成本 35-40k 美元的兩倍,以提供相同數量的頻寬。然而,這沒有考慮到交換器供應商的毛利。如果我們應用 60% 的毛利率,光引擎對最終買家的成本將達到 80k-90k 美元——這比收發器等效物更高。還有其他組件如光纖 shuffle 和其他組件將受到這種毛利堆疊的影響。這解釋了為什麼,取決於收發器支付的成本和交換器供應商獲取的毛利,轉向 CPO 時的成本節省可能並不顯著。

我們可以在下表中看到,在三層網路上從收發器切換到 CPO 時,CPO 組件上的額外毛利使交換器成本增加 81%,這減少了不購買收發器帶來的 86% 節省。總網路成本仍然比使用 DSP 收發器低 31%,但與功耗一樣,伺服器機架在叢集 TCO 中的主導份額意味著總叢集成本只下降 3%。

將網路扁平化到兩層而不是三層可以帶來更多成本節省——高達 7% 的總叢集成本降低,收發器成本下降 86%,總網路成本減少 46%。

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

那麼——如果 CPO 一方面只提供高達 7% 的成本節省和高達 4% 的功率節省,但另一方面引起了對現場服務困難、對可靠性和爆炸半徑的焦慮(無論是否合理),以及失去與多個收發器供應商的議價能力的擔憂——為什麼它被 GPU 雲採用?簡單的答案是目前還沒有被廣泛採用——我們預計近期內超大規模雲內 CPO scale-out 系統不會快速採用。

Scale-up 網路的 CPO

相反,我們認為 CPO 用於 scale-up 是殺手級應用。如前所述,主要的超大規模雲端公司已經在為本十年末部署基於 CPO 的 scale-up 解決方案向供應商做出承諾。

目前,現有的基於銅線的 scale-up 範式由於銅纜的有限距離——在 200Gbit/s 每通道運行時最多兩米——以及每通道頻寬翻倍的難度增加而被推到極限。CPO 可以解決這些問題,因為它可以滿足頻寬密度需求,為未來提供多種頻寬擴展途徑,並解鎖更大的 scale-up 世界規模。

一旦 CPO 部署用於 scale-up 網路,scale-up 域將不再受互連距離的限制。原則上,客戶將能夠將 scale-up 域擴展到任意大的規模。當然,如果想要在允許全對全連接的單層扇出網路內保持 scale-up 域,scale-up 域大小將受到交換器基數的限制。

Scale-out vs Scale-up TAM

Scale-up 架構的網路需求比後端 scale-out 網路要求高得多。GPU 到 GPU 或交換器連接需要更高的頻寬和更低的延遲,以使 GPU 能夠互連,從而可以一致地共享記憶體等資源。

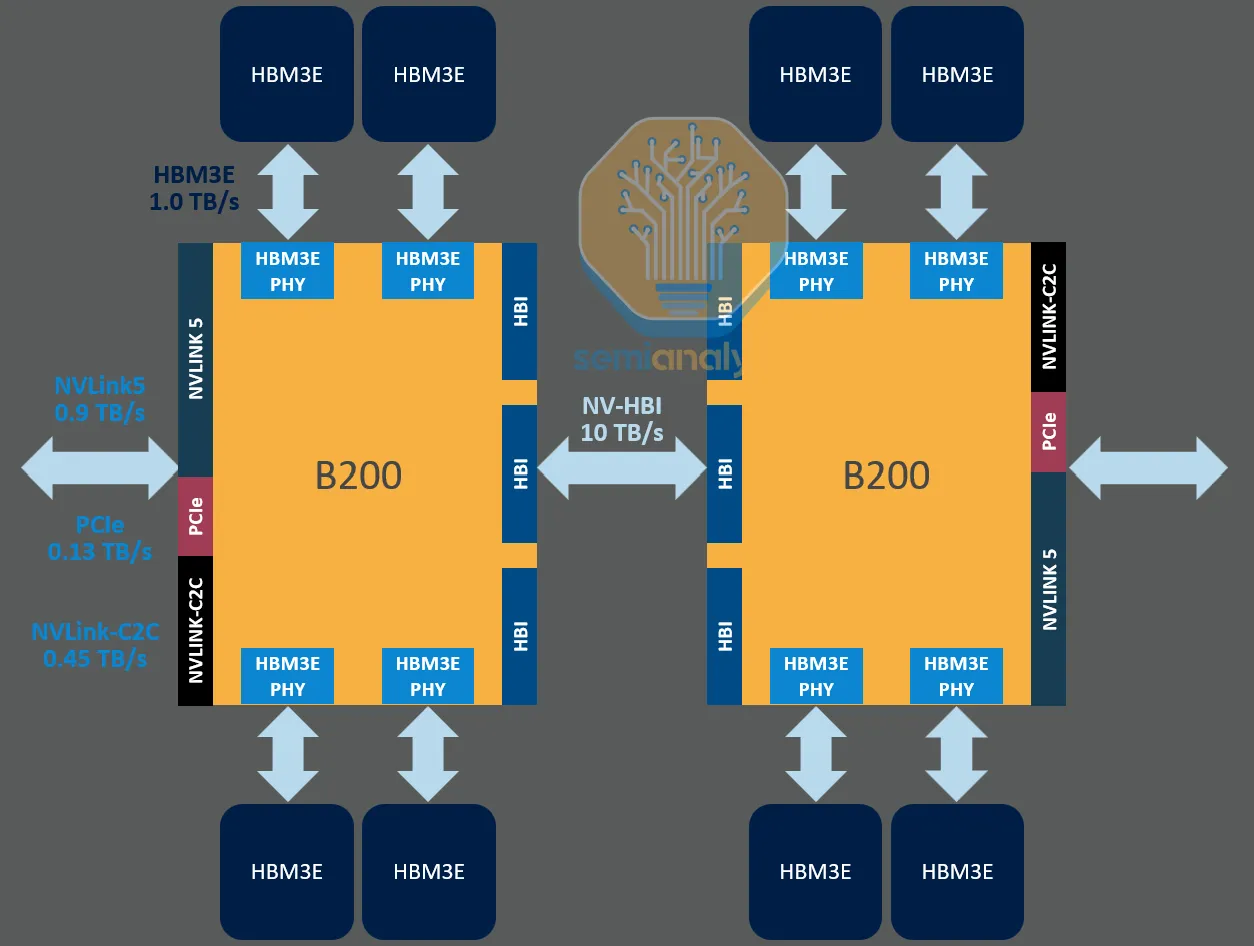

舉例說明,Nvidia Blackwell 上的第 5 代 NVLink 每 GPU 提供 900GByte/s(7,200 Gbit/s)的單向頻寬。這比後端 scale-out 網路上每 GPU 的 100GByte/s(800Gbit/s)(使用 GB300 NVL72 的 CX-8 NIC)多 9 倍。這也產生了對主機更高短線頻寬密度的需求,這一直是推動 GPU SerDes 線速向前發展的動力。

同樣重要的是要認識到,隨著 scale-up 域的規模增加以及 scale-up 互連速度的增長,scale-up 互連(最終是 scale-up CPO)的 TAM 已經大大超過了 scale-out 網路。CPO TAM 可能由 scale-up 而非 scale-out 網路應用主導。

來源:SemiAnalysis

來源:SemiAnalysis

Scale-Up 的銅線 vs 光學:世界規模、密度和距離

目前,scale-up 網路完全在銅線上運行是有充分理由的。在當前可插拔範式中用光學收發器匹配 NVLink 頻寬在成本和功耗方面都是不可承受的,同時還會引入不需要的延遲。計算托盤的面板空間也可能不足以容納所有這些收發器。銅線在這些低延遲、高吞吐量連接方面表現出色。然而,如上所述,銅線的有限距離限制了「世界規模」——可以在單個 scale-up 域內連接的 GPU 數量。

增加 scale-up 世界規模是計算擴展的一個極其重要的途徑。在當今基於推理的模型擴展和測試時計算的體制下,在單個 scale-up 域中添加更多計算、記憶體容量和記憶體頻寬變得越來越關鍵。

Nvidia 的 GB200 系統提供了巨大的性能提升,因為它將世界規模從僅 8 個互連 GPU 提升到全對全拓撲中的 72 個互連 GPU。結果是通過實施在 scale-out 網路上不可行的更複雜的集體通訊技術,解鎖了巨大的吞吐量增益。

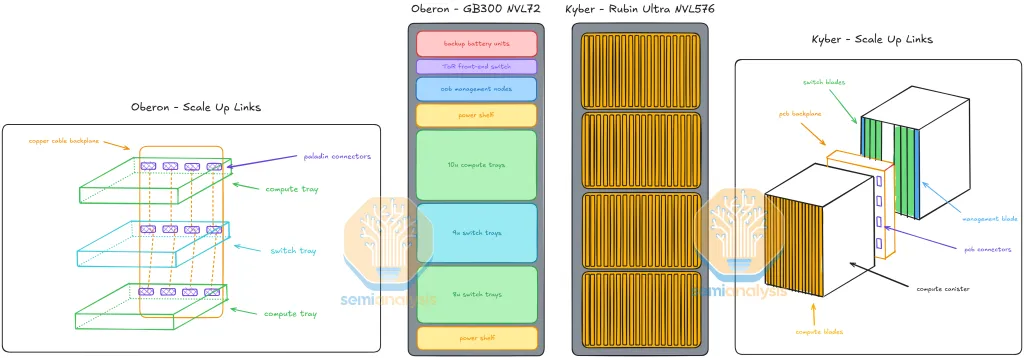

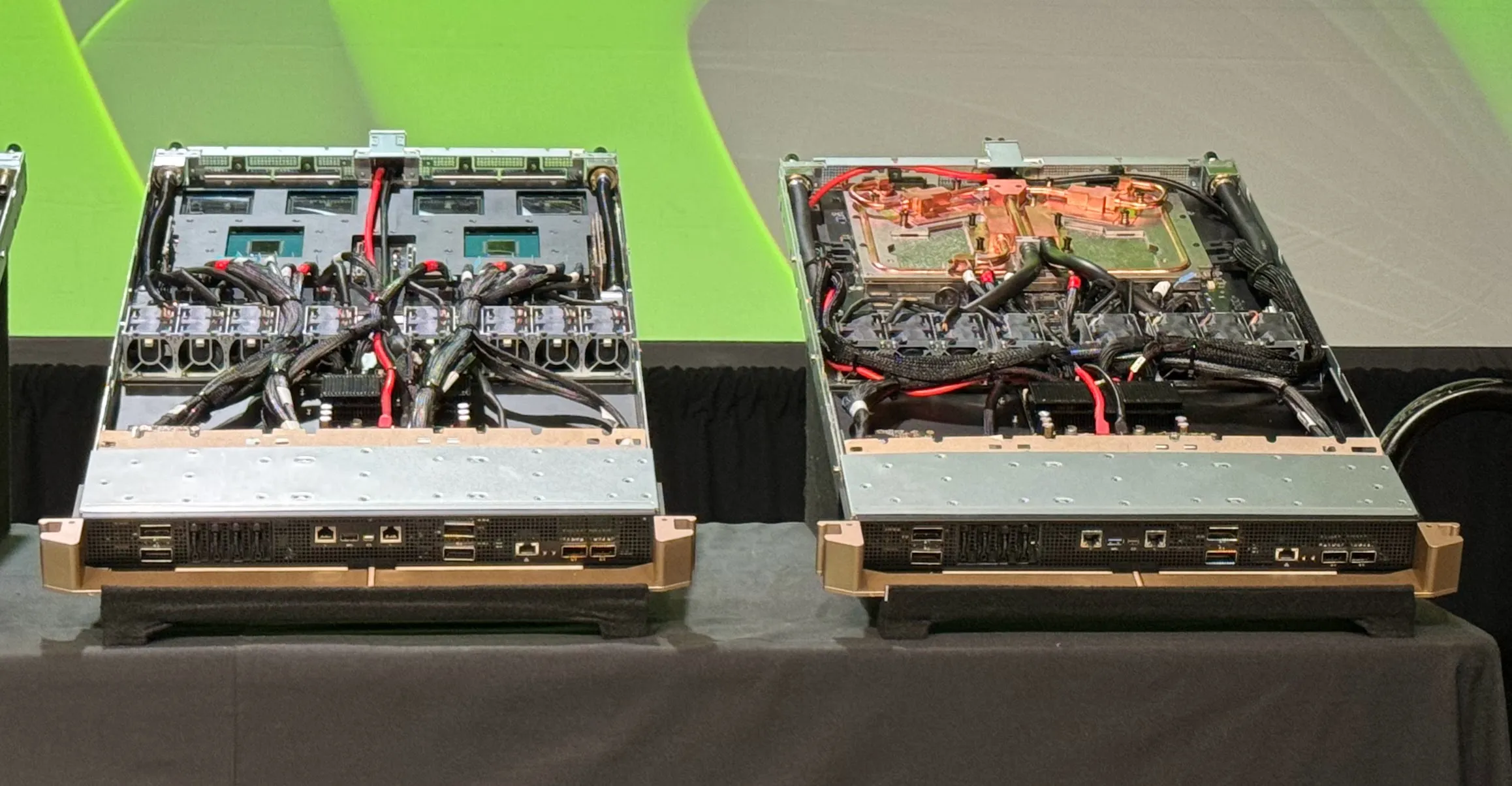

在銅線上,這只能在單個機架的佔地面積內完成,這對電力傳輸、熱管理和可製造性提出了巨大需求。這個系統的複雜性使下游供應鏈仍在努力提高產能。

Nvidia 將繼續堅持銅線。他們還需要將 scale-up 世界規模推得更高,以領先於 AMD 等競爭對手和正在追趕自己 scale-up 網路的超大規模雲端公司。因此,Nvidia 被迫採取極端措施在單個機架內擴展 scale-up 域。Nvidia 在 GTC 2025 上展示的 Rubin Ultra 的極端 Kyber 機架架構可以擴展到 144 個 GPU 封裝(576 個 GPU 裸晶)。這個機架比已經密集的 GB200/300 NVL72 機架密集 4 倍。GB200 已經如此複雜難以製造和部署,Kyber 則更上一層樓。

光學實現了相反的方法,通過跨多個機架擴展來增加世界規模,而不是在密集佔地面積中打包更多加速器,這對電力傳輸和熱密度具有挑戰性。今天使用可插拔收發器是可能的,但同樣,光學收發器的成本以及其高功耗使這不切實際。

來源:SemiAnalysis

來源:SemiAnalysis

Scale-Up 的銅線 vs 光學:擴展頻寬

在銅線上擴展頻寬也越來越困難。使用 Rubin,Nvidia 通過實施新穎的雙向 SerDes 技術實現頻寬翻倍,其中發送和接收操作共享相同的通道,在每通道 224Gbit/s 發送 + 224Gbit/s 接收實現全雙工通訊。在銅線上實現「真正的」每通道 448G 仍然是另一個具有不確定上市時間的艱鉅任務。相比之下,CPO 提供多種頻寬擴展途徑:波特率、DWDM、額外光纖對和調變——所有這些將在本文後面詳細討論。

CPO 何時準備好進入黃金時段?

那麼,如果 CPO 是解決方案,為什麼 Nvidia 不首先為 Rubin Ultra 追求它,而只是為其 scale-out 交換器?這要回到供應鏈不成熟、製造挑戰和客戶對部署的猶豫。Quantum 和 Spectrum CPO 交換器已被引入以幫助提升供應鏈並獲得更多關於資料中心可靠性和可服務性的實際數據。

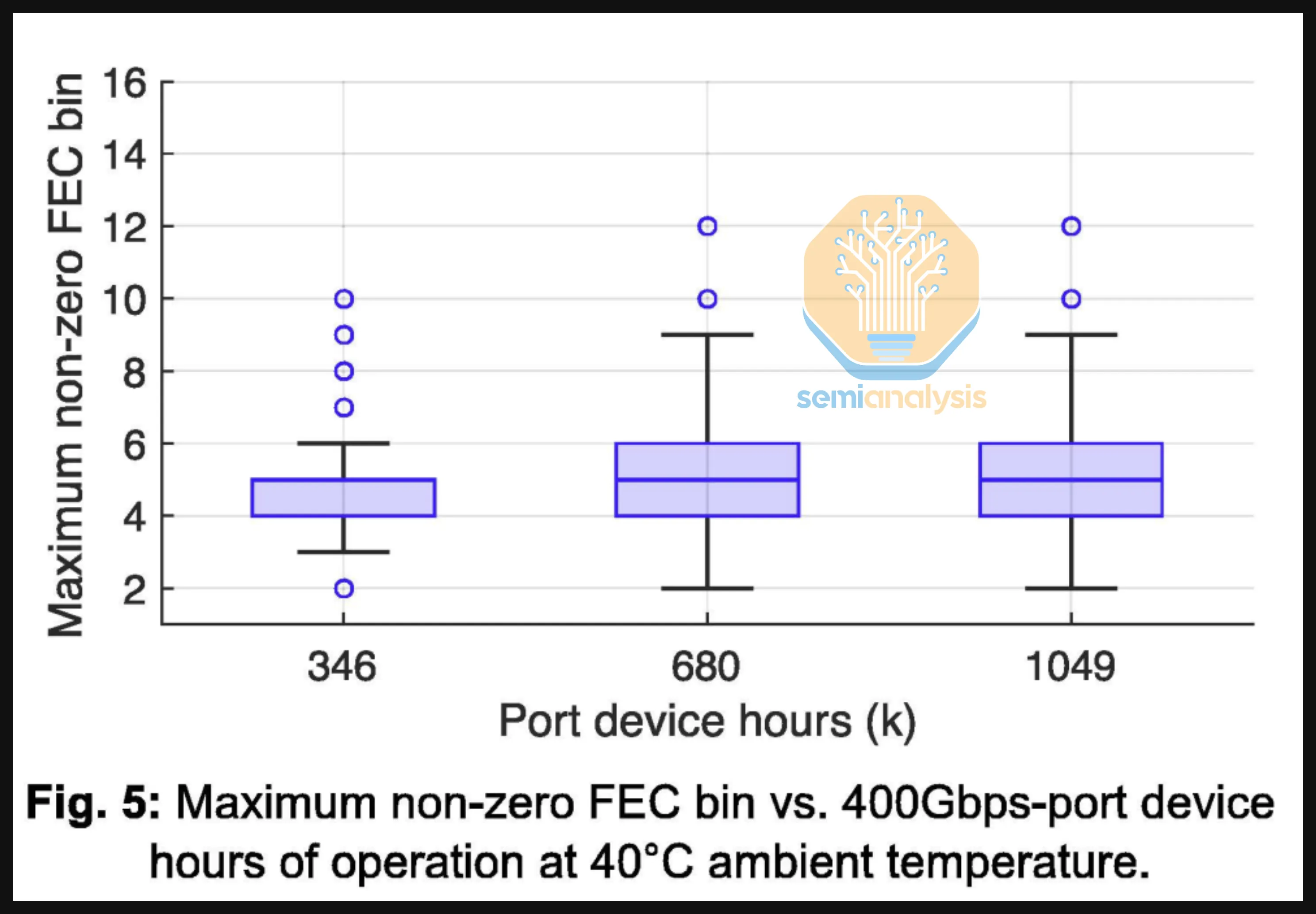

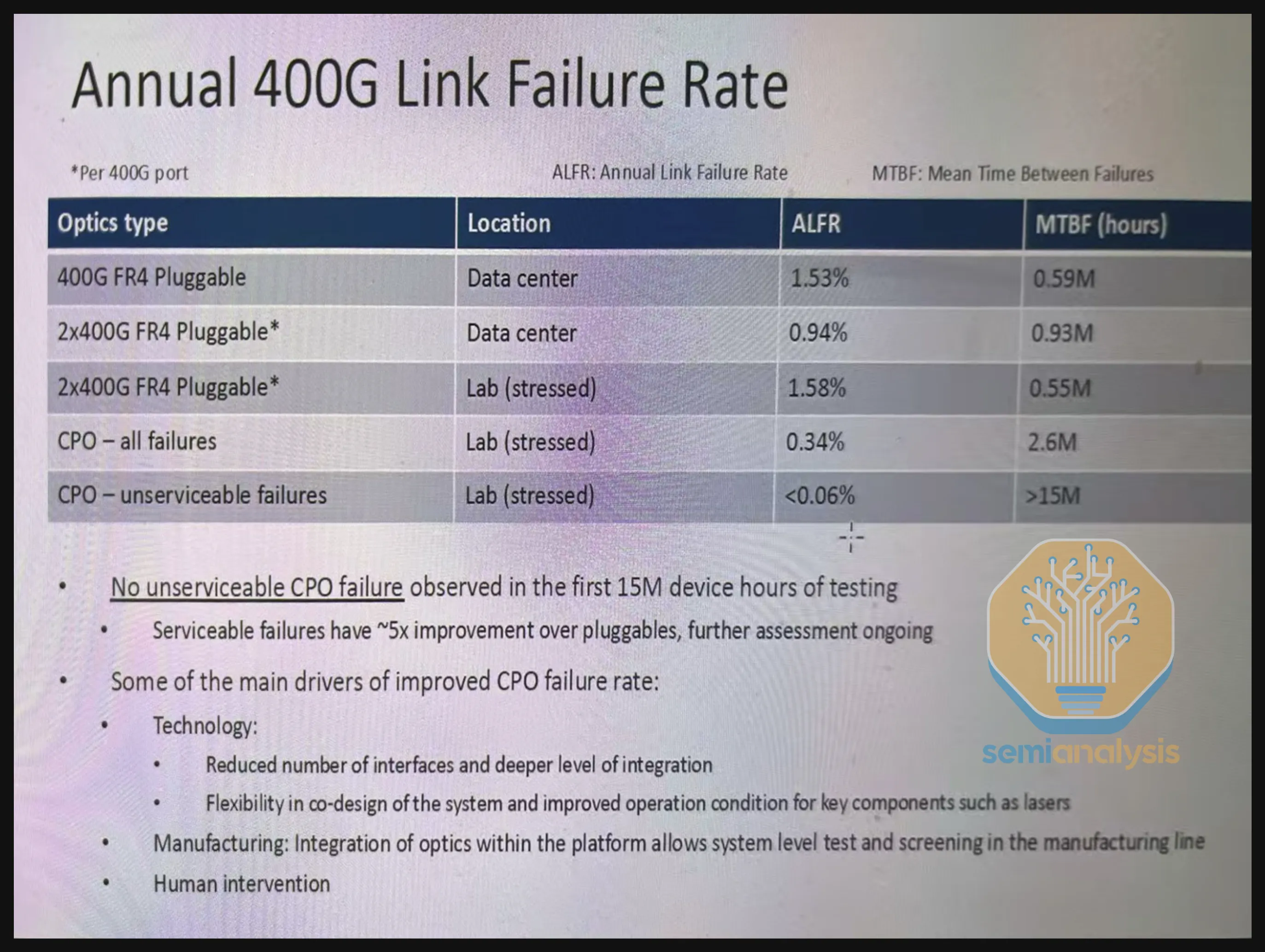

在此期間,Meta 在 ECOC 前後發布的 CPO 可靠性數據提供了一些有用的資訊。Meta 與 Broadcom 合作進行了這項研究。在這項研究中,Meta 進行了一個規模相當大的測試,跨 15 個 Bailly 51.2T CPO 交換器,最多達 1,049k 400G 端口設備小時,並公布了最大非零 KP4 前向糾錯(FEC)bin:

來源:Meta

來源:Meta

論文還解釋了在測試期間,連接中沒有觀察到故障或不可糾正的碼字(UCW),在整個測試期間高達 1,049k 400G 端口設備小時中僅引用了一個 FEC bin > 10 的實例被觀察到。

Meta 沒有止步於此。在 ECOC 上展示同一論文的演講中,他們展示了高達 15M 400G 端口設備小時的擴展結果。這些結果顯示,在前 4M 400G 端口設備小時內沒有 UCW,他們還顯示 400G 2xFR4 收發器的平均故障前時間(MTBF)為 0.5-1M 設備小時(全球 2xFR4 為 550k)vs CPO 的 2.6M 設備小時 MTBF。

來源:Meta

來源:Meta

雖然 15M 端口設備小時聽起來像是一個很大的數字,但這是以 400G 端口小時為單位。所以——一個 51.2T 交換器運行一小時意味著 128 個 400G 端口小時。15 個 51.2T 交換器的 15M 400G 端口小時意味著 7,812 個實際時鐘小時或約 325 天。確實,這個 15M 小時數字經常被簡單地引用為「小時」或「設備小時」,而「端口」部分被省略。雖然高達 4M 端口設備小時的零故障和零 UCW 統計數據非常有用——但行業需要的遠不止在實驗室環境中測試 11 個月的 15 個 CPO 交換器,才能轉向 CPO scale-out 交換並向這項技術投入數十億美元。

在動態現場環境中運行數千個 scale-out 交換器是完全不同的挑戰,這些交換器在生產環境中的表現如何仍有待觀察。與實驗室相比,生產環境中的溫度變化可能更大,導致組件性能或耐久性出現意想不到的變化。Meta 自己的 Llama 3 論文引用了資料中心 1-2% 的溫度變化對功耗波動產生不利影響——這種波動是否會以難以預料的方式影響整個網路架構?

來源:Meta

來源:Meta

即使是聽起來平凡的問題,如資料中心的灰塵,也是支持技術人員的禍根,他們可能花費大量時間清潔光纖端面——當然,CPO 交換器有 LC 或 MPO 類型的前可插拔連接器,但 CPO 交換器機箱內的灰塵呢?0.06% 的不可服務故障率聽起來很有吸引力,但這種故障的爆炸半徑是 64 個 800G 端口。這篇論文也專注於基於 FR 光學的 CPO 交換器,儘管下一代 CPO 交換器將基於 DR 光學。這些只是一些已知的未知數,在現場測試中可能會出現更多未知的未知數。

確實,這些結果在說服業內人士方面具有影響力,因為它們提供了切實的可靠性數據。我們這裡的觀點不是製造恐懼、不確定性或懷疑(FUD),而是呼籲進行更大規模的現場測試,以便行業能夠快速理解和解決意想不到的問題,從而為更廣泛的 CPO 採用鋪平道路,特別是用於 scale-up 網路。

最終,Nvidia 的 scale-out CPO 產品發布是為真正的大規模部署進行的練習運行和管道清理。我們認為,鑑於 scale-up 與 scale-out 相比具有更具說服力的 TCO 和性能/TCO 優勢,部署在 scale-up 方面將更加龐大和有影響力。

此外——當涉及到 scale-out CPO 時,Rubin Ultra 的目標是在 2027 年推出(我們認為最終會是 2027 年末),供應鏈也無法準備好出貨數千萬個這些 CPO 端點以支持 GPU 需求。即使這個時間表對 Nvidia 來說也太雄心勃勃了。這就是為什麼 Feynman 代似乎是 CPO 注入 Nvidia 生態系統的焦點。

現在讓我們深入討論 CPO 是什麼、技術考慮、挑戰以及當今生態系統的狀態。

第二部分:CPO 介紹與實施

CPO 是什麼,為什麼大家都這麼興奮?

CPO 將光引擎直接整合在與高性能計算或網路 ASIC 相同的封裝或模組內。這些光引擎將電信號轉換為光信號,實現通過光連接的高速數據傳輸。光連接必須用於超過幾米距離的數據通訊,因為銅線上的高速電通訊無法超過幾米。

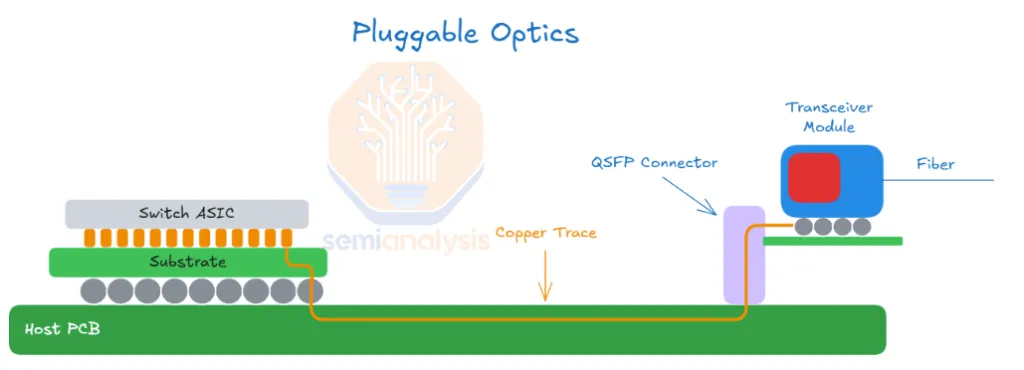

今天,大多數電到光的轉換通過可插拔光學收發器進行。在這種情況下,電信號將從交換器或處理晶片通過 PCB 行進十幾厘米或更多到機箱前板或後板的物理收發器籠。可插拔光學收發器位於該籠中。收發器接收電信號,該信號由光學數位信號處理器(「DSP」)晶片重新調節,然後發送到將電信號轉換為光信號的光引擎組件。光信號然後可以通過光纖傳輸到連接的另一側,在那裡另一個收發器經歷這個過程的反向,將光信號一直轉換回電信號到目標矽。

在這個過程中,電信號在到達光連接之前經過相對較長的距離(至少對於銅線來說)並有多個轉換點。這導致電信號惡化,需要大量功率和複雜電路(SerDes)來驅動和恢復它。為了改善這一點,我們需要縮短電信號需要行進的距離。這帶來了「共封裝光學」的概念,其中在可插拔收發器中發現的光引擎被改為與主機晶片共封裝。這將電跡線長度從數十厘米減少到數十毫米,因為光引擎更靠近 XPU 或交換器 ASIC。這顯著降低功耗,提高頻寬密度,並通過最小化電互連距離和減輕信號完整性挑戰來降低延遲。

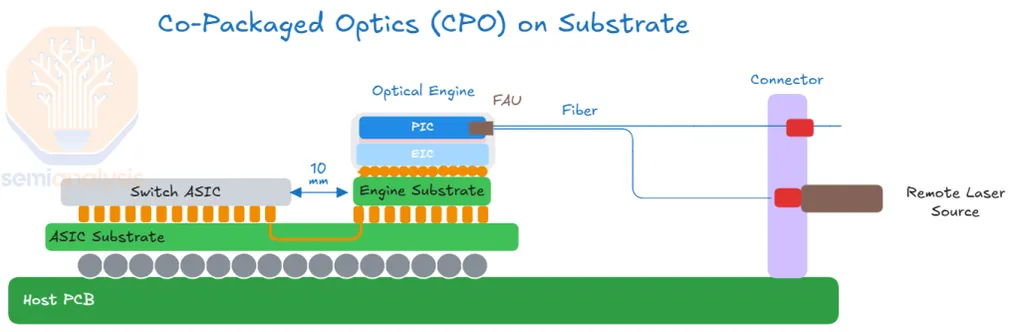

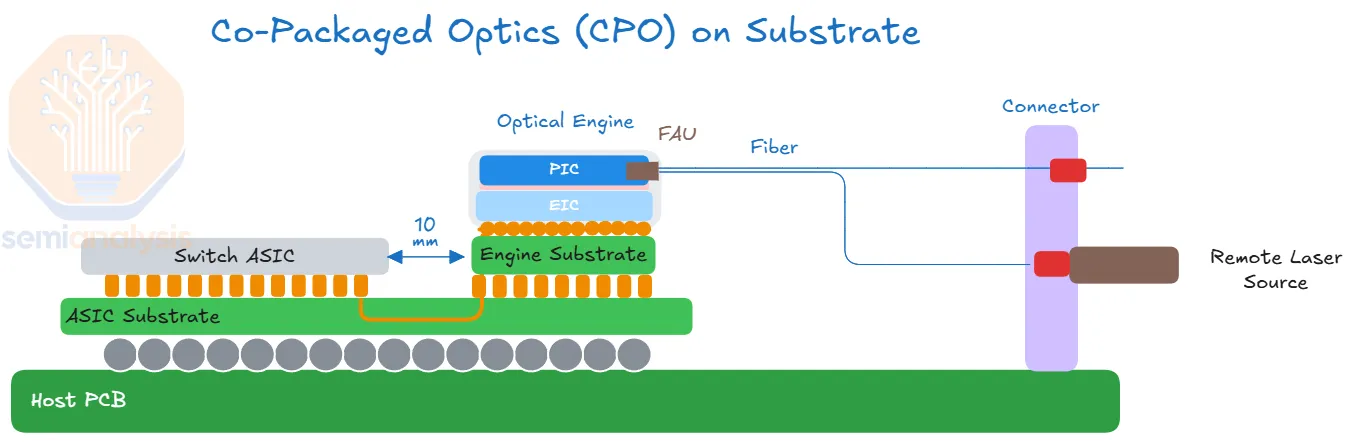

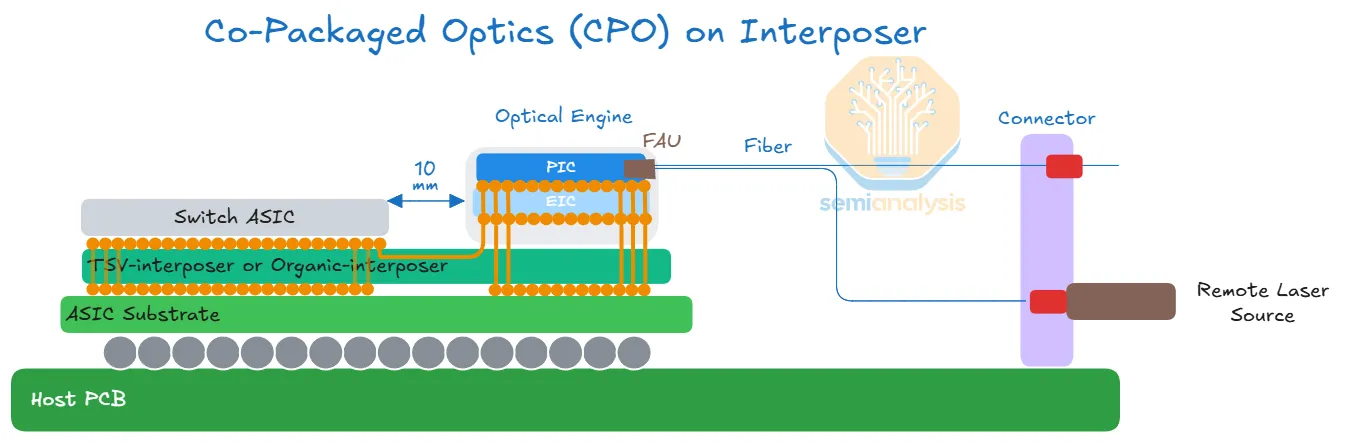

下面的示意圖說明了一個 CPO 實施,其中有一個光引擎與計算或交換晶片位於同一封裝上。光引擎最初將在基板上,未來 OE 將放置在中介層上。

來源:SemiAnalysis

來源:SemiAnalysis

來源:SemiAnalysis

來源:SemiAnalysis

今天,如下圖所示的前可插拔光學解決方案是無處不在的。這張圖的主要要點是說明電信號在到達收發器中的光引擎之前需要經過很長的距離(15-30cm)通過銅跡線或飛越電纜。如上所述,這也需要長距離(LR)SerDes 來驅動到可插拔模組。

來源:SemiAnalysis

來源:SemiAnalysis

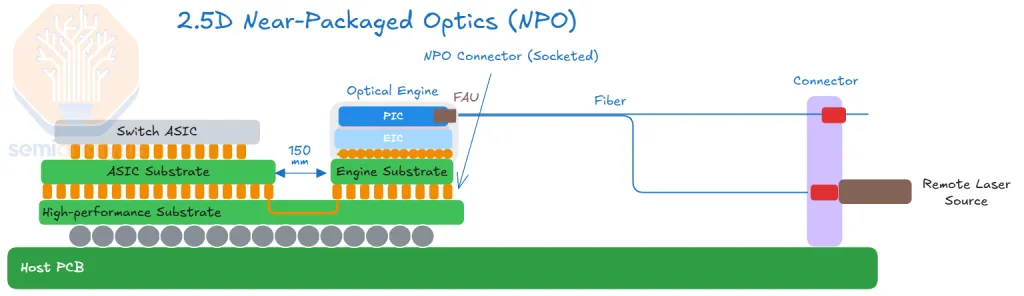

此外,還有介於 CPO 和傳統前可插拔光學之間的中間實施,如近封裝光學(NPO)和板載光學(OBO)。

近年來,NPO 已成為 CPO 的中間步驟。NPO 有多種定義。NPO 是 OE 不直接位於 ASIC 基板上,而是共封裝到另一個基板上。光引擎保持可插拔性,可以從基板上拆卸。電信號仍將從 XPU 封裝上的 SerDes 通過某些銅通道行進到光引擎。

來源:SemiAnalysis

來源:SemiAnalysis

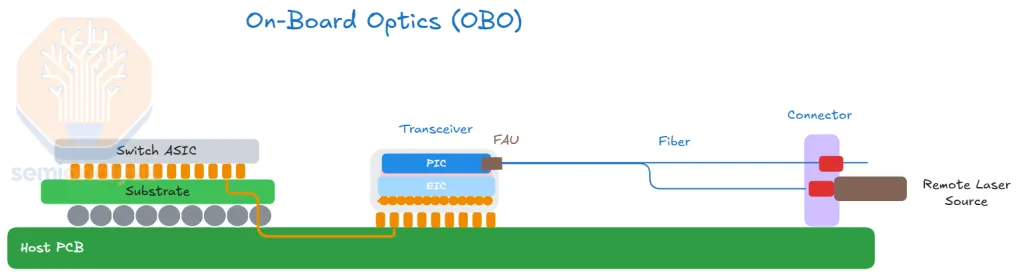

還有板載光學(OBO),它將光引擎整合到機箱內的系統 PCB 上,使其更靠近主機 ASIC。然而,OBO 繼承了 CPO 的許多挑戰,同時在頻寬密度和功率節省方面提供的好處更少。我們將 OBO 視為「兩全其害」,因為它結合了 CPO 的複雜性,同時繼承了前可插拔光學的一些限制。

來源:SemiAnalysis

來源:SemiAnalysis

共封裝銅線

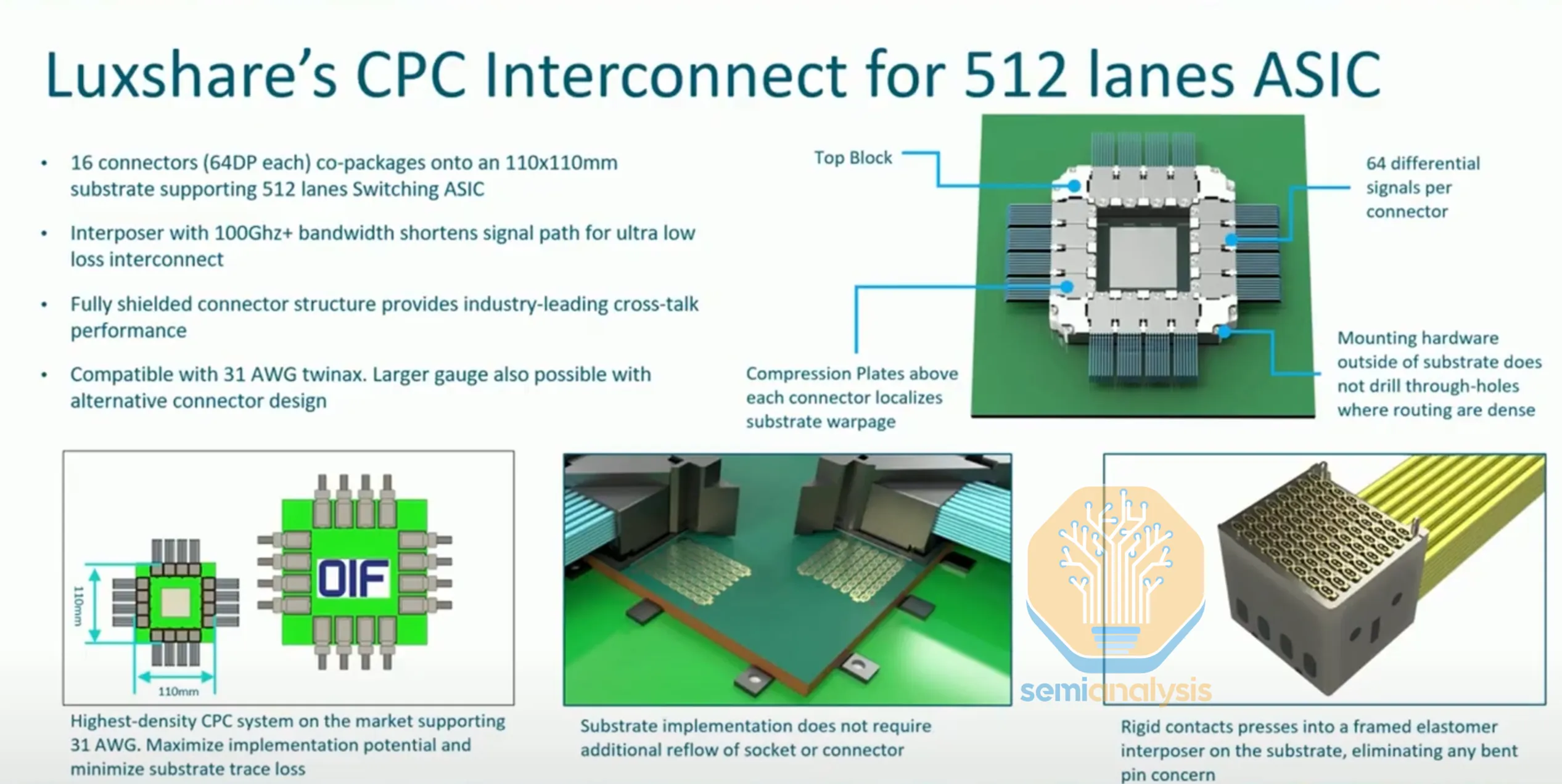

CPO 的另一個替代方案是「共封裝銅線」(CPC)。CPC 使用銅纜直接從基板上的連接器出來。CPC 使用的電纜與飛越電纜相同,目的也相同:繞過 PCB 跡線。CPC 進一步發展了飛越電纜,插座從封裝基板本身開始。使用的電纜是雙軸電纜(Twinax 電纜),它們絕緣良好以減少串擾,與傳統電跡線相比插入損耗顯著降低。儘管這個解決方案仍然使用銅線,但它在信號完整性方面提供了關鍵優勢。CPC 可以提供部署 448G SerDes 的實用途徑,以允許另一個離封裝互連的擴展。

來源:LuxShare

來源:LuxShare

來源:Luxshare

來源:Luxshare

CPC 的挑戰在於封裝基板的額外複雜性。基板必須將電源和信號路由到數千根這些電纜。儘管有這個挑戰,CPC 仍然比 CPO 簡單得多,後者仍然需要克服供應鏈多個部分的許多製造障礙。我們認為 CPC 對某些短距離應用特別有吸引力,如機架內 scale-up 連接,我們將在下面探討。通過繞過損耗大的 CCL 跡線,CPC 可能是實現 448G 線速的技術。CPC 也被非常廣泛地研究用於實現 448G,因為這種頻寬的信號在通過 PCB 運行時會經歷不可接受的衰減。

CPO 市場準備的過去障礙:為什麼是現在?

儘管技術上優越,由於多種推高成本的挑戰,CPO 在實際應用中的採用非常有限。這些包括:封裝(成本高於 OE 本身)和製造的複雜性、可靠性和良率問題,以及由緊密整合的光學和電子元件產生的熱管理問題。另一個障礙是缺乏全行業的標準化。此外,客戶擔心可服務性,這阻礙了從傳統可插拔光學到 CPO 解決方案的過渡。

另一個關鍵的客戶焦慮是,通過採用 CPO,他們可能會失去控制成本的能力。與更大數量的收發器公司議價比與較小的交換器供應商集議價要容易得多。

與此同時,可插拔光學——CPO 將取代的現有技術——繼續改進,對於幾乎所有應用仍然提供足夠好的性能,終端用戶焦慮也少得多。

在第二部分的剩餘部分,我們將進一步深入採用 CPO 的推動因素。我們將從解釋 SerDes 擴展如何達到平台期開始,使其他接口類型如 Wide I/O 結合 CPO 成為必要,然後進入製造考慮和上市。我們將討論關鍵的單獨 CPO 組件,如光引擎、光纖耦合、外部雷射光源和調變器。最後,我們將涵蓋 CPO 擴展頻寬的路線圖。

超越基於 DSP 的收發器演進:從 LPO 到 CPO

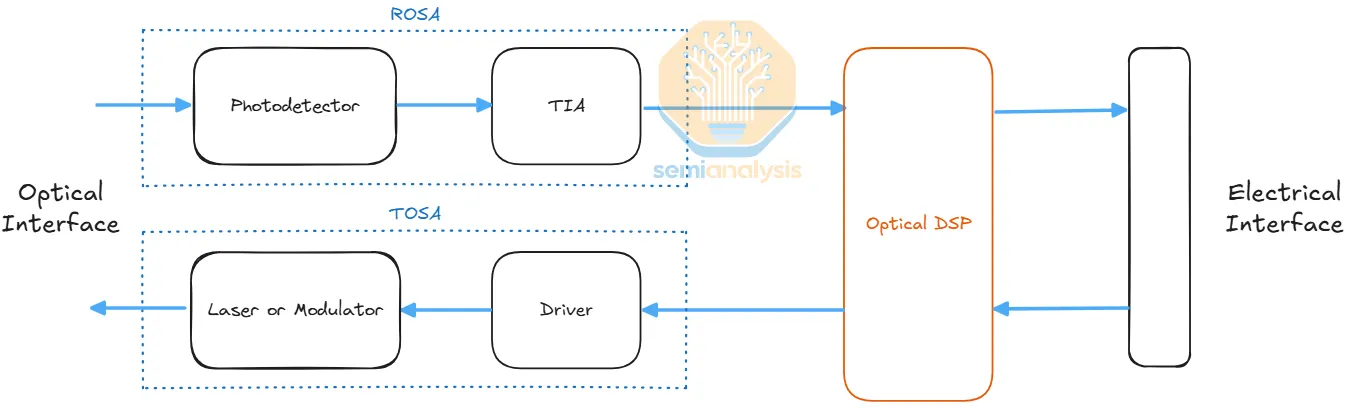

DSP 收發器處理光信號的發送和接收,並包含一個負責電光轉換的「光引擎」(OE)。OE 由驅動器(DRV)和調變器(MOD)組成以發送光信號,以及跨阻放大器(TIA)和光電探測器(PD)以接收光信號。

另一個重要組件是光學 DSP 晶片,有時將驅動器和/或 TIA 整合到一個封裝中。從主機交換或處理晶片發送的高頻電信號需要經過相對較長的距離通過損耗大的銅跡線才能到達伺服器機箱前面的收發器。DSP 負責重新定時和重新調節這個信號。它進行糾錯和時鐘/數據恢復,以補償電信號從交換器或 ASIC 矽通過基板或其他傳輸介質時的電信號退化和衰減。對於調變,在 PAM4 調變(4 電平脈衝幅度調變)的情況下,DSP 將二進制信號映射到四個不同的幅度電平,以增加每信號的位數,允許更高的比特率和更多的頻寬。

來源:SemiAnalysis

來源:SemiAnalysis

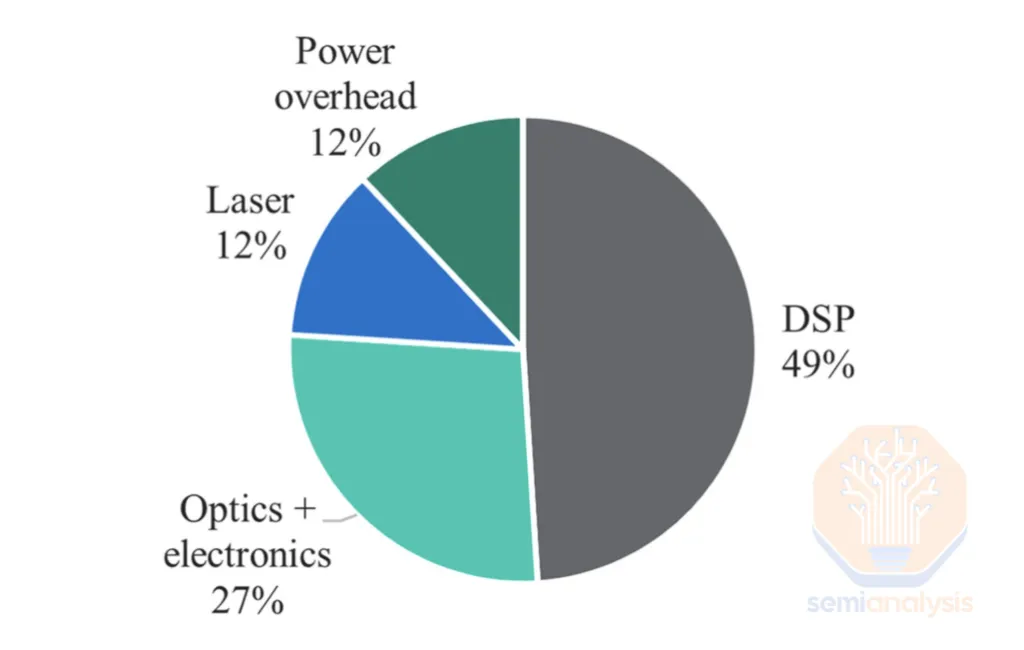

DSP 晶片是收發器內最耗電和昂貴的組件之一(如果不是最多的話)。對於 800G SR8 收發器——DSP 佔模組總功耗的近約 50%,這就是為什麼擺脫 DSP 受到如此多關注的原因。

來源:Dr. Radha Nagarajan et al.: Recent Advances in Low-Power Digital Signal Processing Technologies for Data Center Applications

來源:Dr. Radha Nagarajan et al.: Recent Advances in Low-Power Digital Signal Processing Technologies for Data Center Applications

一個使用兩層 InfiniBand 網路構建的 18k GB300 叢集將需要 18,432 個 800G DR4 收發器和 27,648 個 1.6T DR8 收發器。使用 DSP 產生的額外成本和功率需求可以大大增加總持有成本。為 800G DSP 預算 6-7W,為 1.6T DSP 預算 12-14W,這將為整個叢集僅後端網路增加 480kW 的 DSP 功率,或每伺服器機架約 1.8kW。當從高端品牌供應商採購時,收發器可以佔叢集總持有成本的近 10%。因此——佔典型收發器功耗的 50% 和 BOM 的 20-30%——有些人將 DSP 視為成本和功耗效率的頭號公敵。

來源:SemiAnalysis AI 網路模型

來源:SemiAnalysis AI 網路模型

對 DSP 的討伐

DSP 佔據的高成本和功率比例促使行業尋找可以取代 DSP 的技術。對 DSP 的第一波攻擊是線性可插拔光學(LPO)——試圖完全移除 DSP,讓來自交換器的 SerDes 直接驅動收發器中的 TX 和 RX 光學元件。然而,LPO 還沒有起飛。

CPO 將 LPO 概念更進一步,將光引擎放置在與計算或交換晶片相同的封裝上。CPO 的一個關鍵好處是,收發器中發現的 DSP 不再需要,因為主機和光引擎之間的距離非常短。CPO 也比 LPO 走得更遠,因為它通過消除對功耗和面積飢餓的 LR SerDes 的需求,轉而使用更短距離的 SerDes 或甚至在寬 I/O 接口的情況下使用時鐘轉發的寬 D2D SerDes,解鎖了更大的晶片短線密度。

經常被引用的說法是 CPO 在過去二十年中一直「近在眼前」——但為什麼它這麼長時間都沒有起飛。為什麼行業更願意堅持使用可插拔 DSP 收發器?

可插拔收發器的一個關鍵優勢是其高互操作性。通過標準形式因素如 OSFP 和 QSFP-DD 以及對 OIF 標準的遵守,客戶通常可以獨立於交換器和伺服器供應商選擇收發器供應商,享有採購靈活性和更強的議價能力。

另一個巨大優勢是現場可服務性。安裝和更換收發器很簡單,因為它們可以由一對遠端手從交換器或伺服器機箱中拔出。相比之下,使用 CPO,光引擎中的任何故障都可能使整個交換器無法使用。即使是可服務的故障也可能難以排除和修復。通常,雷射是最常見的故障點,大多數 CPO 實施現在使用可插拔的外部雷射光源以獲得更好的可服務性和可更換性,但對於其他非可插拔 CPO 組件故障的焦慮仍然存在。

為什麼選擇 CPO?I/O 挑戰、頻寬密度和瓶頸

除了擺脫耗電和昂貴的 DSP 以及最小化或消除 LR SerDes 的使用外,採用 CPO 的另一個巨大好處是相對於能耗的更大互連頻寬密度。

頻寬密度衡量每單位面積或通道傳輸的數據量,反映了有限空間如何有效地用於高速數據傳輸。能源效率量化傳輸一個數據單位所需的能量。

因此,相對於能耗的互連頻寬密度是確定給定互連客觀質量的非常重要的優值(FoM)。當然,最佳互連是也符合距離和成本參數的互連。

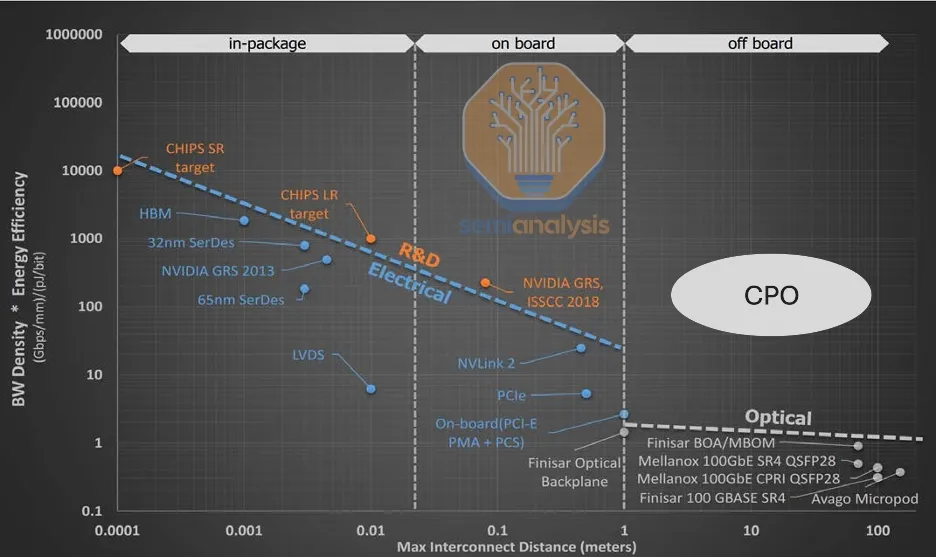

在檢查下面的圖表時,一個明顯的趨勢出現:這個優值隨著距離的增加而呈指數級惡化。此外,從純電接口轉移到需要光電轉換的接口會導致效率大幅下降——可能下降一個數量級。這種下降是因為需要能量將信號從晶片驅動一定距離到收發器所在的前面板。還需要更多能量為光學 DSP 供電。基於 CPO 的通訊的優值曲線完全高於可插拔。如下圖所示,CPO 在相同距離範圍內提供更多的每面積每消耗能量的頻寬密度,使其成為客觀上更好的互連。

來源:G Keeler, DARPA 2019, SemiAnalysis

來源:G Keeler, DARPA 2019, SemiAnalysis

這張圖也說明了格言「能用銅線就用銅線,必須用光學時才用光學。」可用時,銅線上的短距離通訊更優。Nvidia 通過其機架級 GPU 架構擁抱這一信條,該架構的唯一目的是推動機架內密度的極限,以最大化可以通過銅線連接在一起的 GPU 數量。這是 GB200 NVL72 使用的 scale-up 網路架構背後的原理,Nvidia 在其 Kyber 機架中將這個想法更進一步。然而——CPO 的成熟使其 FoM 曲線的這部分對於 scale-up 變得可行,並從性能/TCO 角度來看是值得的,這只是時間問題。

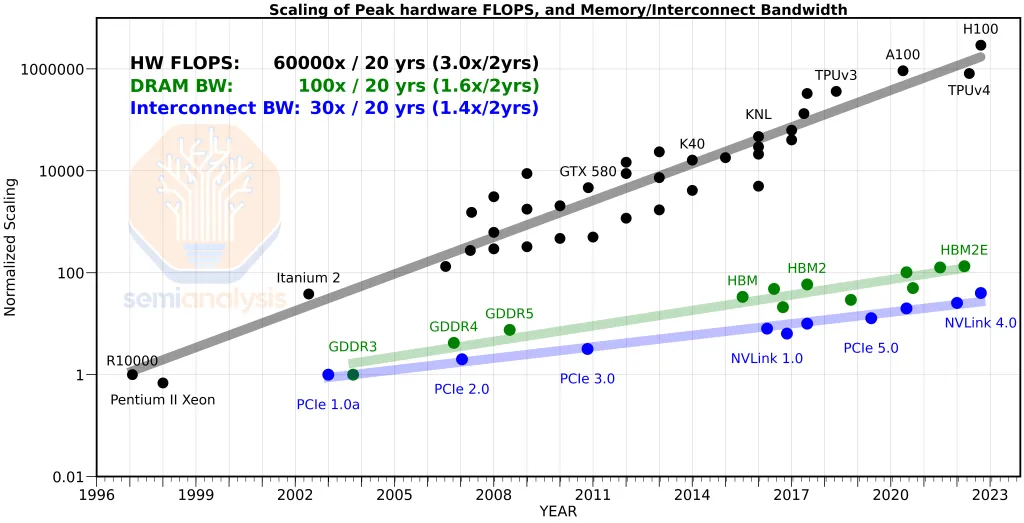

輸入/輸出(I/O)減速帶和路障

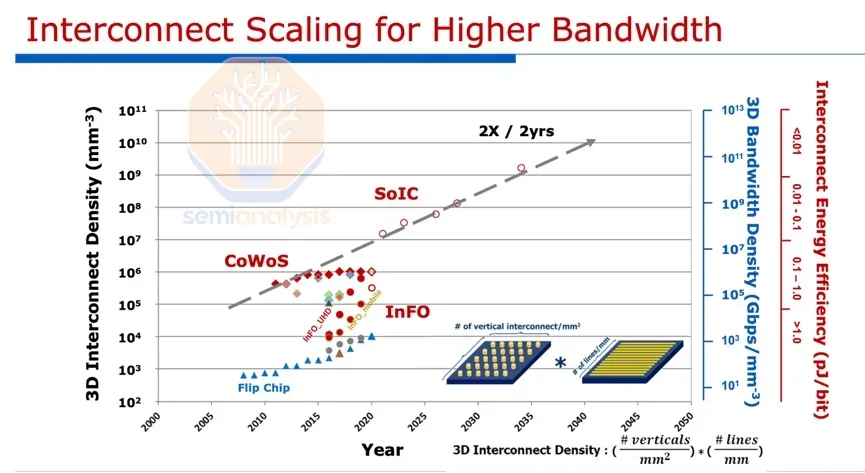

雖然電晶體密度和計算(以 FLOP 表示)擴展良好,但 I/O 擴展慢得多,在整體系統性能中造成瓶頸:離晶片 I/O 的可用短線有限,因為離開晶片的數據需要通過有機封裝基板上有限數量的 I/O 逃逸。

此外,增加每個單獨 I/O 的信號速度變得越來越具有挑戰性和耗電,進一步限制了數據移動。這是為什麼互連頻寬相對於其他計算趨勢在過去幾十年中擴展如此緩慢的一個關鍵原因。

來源:Amir Gholami

來源:Amir Gholami

由於單個倒裝晶片 BGA 封裝中凸塊數量的限制,HPC 應用的離封裝 I/O 密度已經趨於平穩。這是對擴展逃逸頻寬的約束。

來源:TSMC

來源:TSMC

電 SerDes 擴展瓶頸

由於 I/O 數量有限,實現更多逃逸頻寬的方法是推動每個 I/O 信號的頻率。今天,Nvidia 和 Broadcom 處於 SerDes IP 的領先地位。Nvidia 在 Blackwell 中出貨 224G SerDes,這是實現其超快 NVLink 的關鍵。同樣,Broadcom 自 2024 年底以來一直在其光學 DSP 中採樣 224G SerDes。行業中出貨最多 AI FLOP 的兩家公司也在高速 SerDes IP 方面領先,這絕非巧合。這加強了 AI 性能和吞吐量之間的根本聯繫,其中最大化數據移動效率與提供原始計算能力同樣重要。

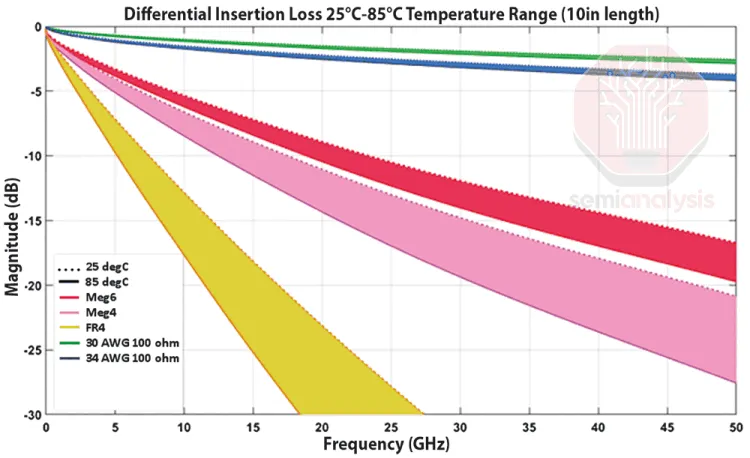

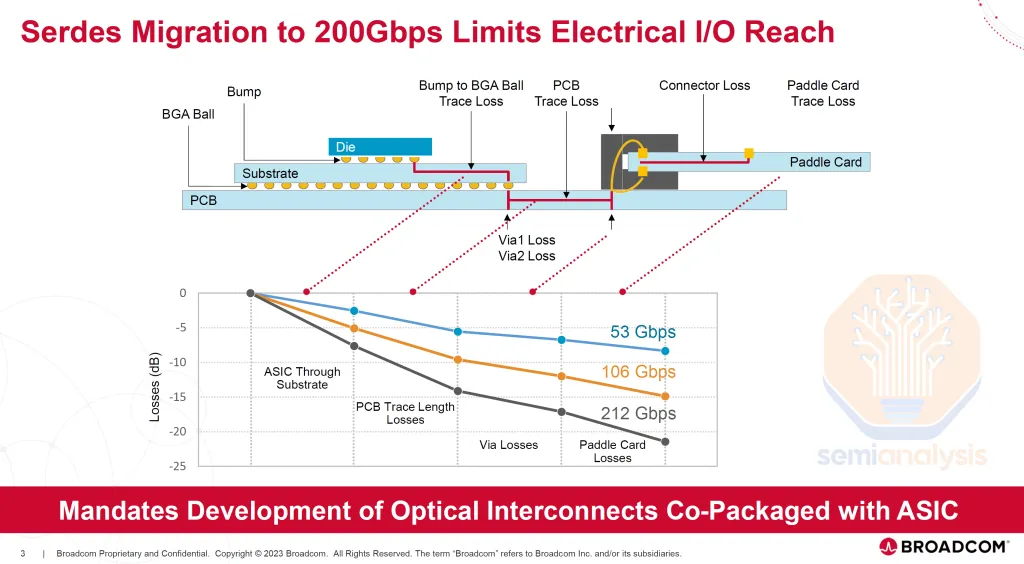

然而,在理想的距離上提供更高的線速變得越來越具有挑戰性。隨著頻率增加,插入損耗上升,如下圖所示。我們看到損耗在更高的 SerDes 信號速度下增加,特別是當信號路徑延長時。

來源:Broadcom

來源:Broadcom

SerDes 擴展正在接近平台期。更高的速度只能在非常短的距離上維持,而不需要額外的信號恢復組件——這反過來增加了複雜性、成本、延遲和功耗。達到 224G SerDes 一直很困難。

展望 448G SerDes,驅動超過幾厘米的可行性仍然更加不確定。Nvidia 在 Rubin 中通過使用雙向 SerDes 技術實現每電通道 448G 的連接。實現真正的 448G 單向 SerDes 需要進一步開發。我們可能需要轉向更高階的調變,如 PAM6 或 PAM8,而不是自 56G SerDes 時代以來一直流行的 PAM4 調變。使用 PAM4(每信號編碼 2 位)來達到 448G 將需要 244Gbaud 的波特率,由於功耗過高和插入損耗,這可能是不可持續的。

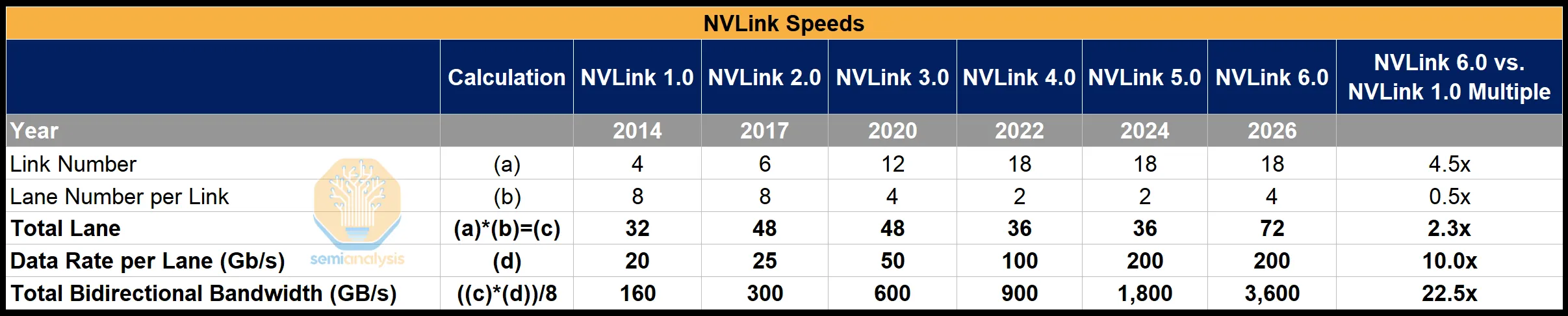

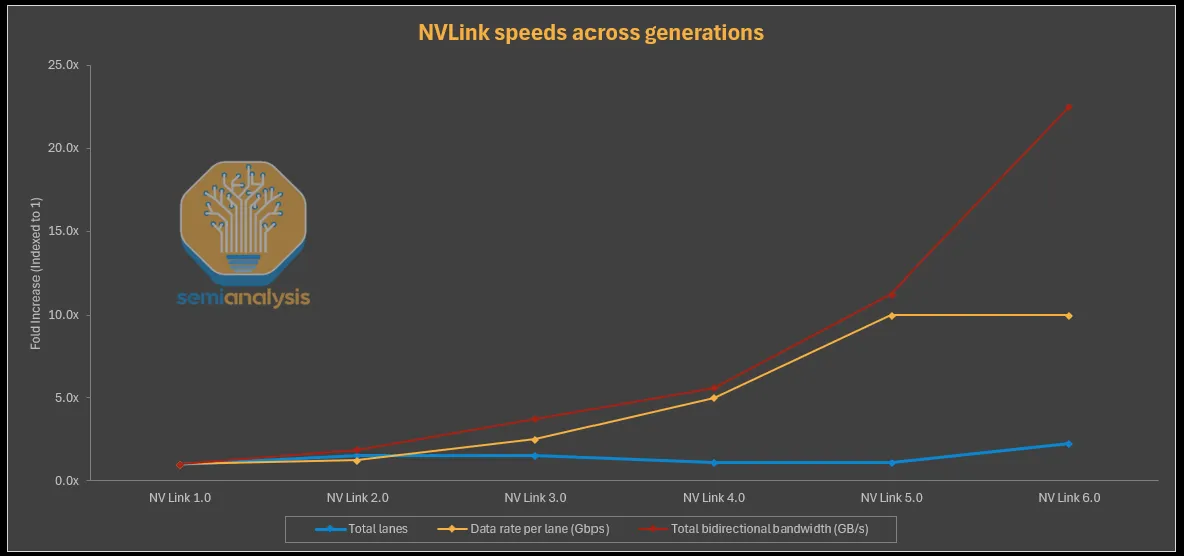

SerDes 擴展平台期作為 NVLink 擴展的路障

在 NVLink 協議中,NVLink 5.0 中的頻寬比 NVLink 1.0 增加了超過 11 倍。然而,這種增長並不是來自通道數量的顯著增加,通道數量僅從 NVLink 1.0 的 32 通道略微增加到 NVLink 5.0 的 36 通道。擴展的關鍵驅動因素是 SerDes 通道速度從 20G 到 200G 的 10 倍增長。然而,在 NVLink 6.0 中,Nvidia 預計將保持 200G SerDes,這意味著它必須通過通道數量翻倍來實現——它通過使用雙向 SerDes 巧妙地實現了這一點,在使用相同數量的物理銅線的同時有效地將通道數量翻倍。超越這一點,擴展 SerDes 速度和克服有限的短線可用性以容納更多通道將變得越來越困難,總逃逸頻寬將停滯。

擴展逃逸頻寬對於吞吐量是差異化因素的領先公司至關重要。對於 Nvidia,其 NVLink scale-up 架構是一個重要的護城河,這個路障可能使 AMD 等競爭對手和超大規模雲端公司更容易追趕。

來源:Nvidia, SemiAnalysis

來源:Nvidia, SemiAnalysis

來源:Nvidia, SemiAnalysis

來源:Nvidia, SemiAnalysis

這個困境的解決方案——或者換一種說法是必要的妥協——是盡可能縮短電 I/O 並將數據傳輸盡可能靠近主機 ASIC 卸載到光連接,以實現更高的頻寬。這就是為什麼 CPO 被認為是互連的「聖杯」。CPO 允許光通訊發生在 ASIC 封裝上,無論是通過基板還是中介層。電信號只需要通過封裝基板行進幾毫米,或者理想情況下通過更高質量的中介層行進更短的距離,而不是數十厘米通過損耗大的銅包層壓板(CCL)。

SerDes 可以改為針對更短距離進行優化,與等效的長距離 SerDes 相比需要更少的電路。這使設計更容易,同時消耗更少的功率和矽面積。這種簡化使更高速度的 SerDes 更容易實現,並延長了 SerDes 擴展路線圖。儘管如此,我們仍然受到傳統頻寬模型的約束,其中頻寬密度繼續與 SerDes 速度成比例擴展。

為了實現更高的頻寬密度,Wide I/O PHY 是在極短距離上的更好選擇,比 SerDes 接口提供更好的每消耗功率頻寬密度。Wide I/O 也需要更先進的封裝。然而,在 CPO 的情況下,這是一個無關緊要的問題:封裝已經非常先進,因此整合 Wide I/O PHY 幾乎不會增加封裝複雜性。

Wide I/O vs SerDes

一旦不再需要將電信號驅動到相對較長的距離,我們可以通過使用寬接口完全逃離序列化接口,這些寬接口在短距離上提供更好的短線密度。

一個這樣的例子是 UCIe 接口。UCIe-A 可以提供高達約 10 Tbit/s/mm 的短線密度,專為先進封裝設計(即通過中介層接口的晶片小塊,距離低於 2mm)。在一個光刻限制尺寸晶片的長邊上,這是高達 330 Tbit/s(41TByte/s)的離封裝頻寬。這是兩邊共 660 Tbit/s 的雙向頻寬。這與 Blackwell 的 23.6 Tbit/s 離封裝頻寬相比,相當於約 0.4 Tbit/s/mm 的短線密度,差異很大。

來源:SemiAnalysis

來源:SemiAnalysis

來源:SemiAnalysis

來源:SemiAnalysis

當然——這不是一個同類比較,因為這些離封裝 PHY 需要驅動很長的距離。如果說有什麼的話,這正是正在說明的要點:使用 CPO,距離不再是一個考慮因素,因為信號不會被電驅動很長的距離。在 10 Tbit/s/mm 的頻寬密度下,瓶頸不再在電接口上,而是在連接的其他部分,即另一側的光纖上可以逃逸多少頻寬。

到達這個約束是一個離今天現實非常遙遠的終點狀態,OE 將必須與主機共享一個中介層。將 CPO 整合到中介層本身上比可靠地將 OE 整合在基板上更遙遠。基板上的 PHY 性能當然較差,UCIe-S 提供約 1.8Tbit/s/mm 的短線密度。這仍然是我們認為 224G SerDes 提供的約 0.4Tbit/s/mm 的顯著提升。

然而,Broadcom 和 Nvidia 儘管寬接口提供了優勢,仍在其路線圖上堅持電 SerDes。主要原因是他們相信他們仍然可以擴展 SerDes,並且他們需要為銅線設計,特別是因為光學的採用緩慢。看起來混合共封裝銅線和共封裝光學解決方案也將繼續存在,要求他們為兩者進行優化。這種方法被採用是為了消除對不同解決方案進行多次流片的需要。

連接韌性

連接韌性和可靠性是 CPO 技術的其他非常重要的驅動因素。在大型 AI 叢集中,連接停機時間是整體叢集可用性的重要貢獻者,即使是連接可用性和穩定性的小幅改進也能為基礎設施投資提供很大的回報。

今天,在接近 100 萬個連接和可插拔模組的大規模 AI 叢集中,每天可能有數十次連接中斷。其中一些是組件故障或硬體質量導致的「硬」故障,而許多是由各種根本原因導致的「軟」故障,這些原因源於基於可插拔解決方案的固有複雜性和變異性。故障模式有一個長尾,包括但不限於信號完整性問題和變化、連接器和引線焊接質量、組件和引腳上的污染、噪聲注入和其他瞬態效應。與組件故障幾乎沒有相關性。80% 因某些連接故障而退回的光學模組是「未發現故障」。

CPO 通過以下方式顯著減少大規模 AI 網路中高速信號路徑的固有複雜性和變異性:

-

顯著減少光學接口中的組件數量。光子級和晶片/封裝級的高度整合降低了關鍵高速組裝的複雜性,並提高了系統級的可靠性和良率。E/O 接口的數量也減少了,從而最小化了每個接口處發生的功率損失

-

顯著改善主機 ASIC(如交換器)和光引擎之間主機電接口的信號完整性。通過將光引擎封裝在具有非常明確和確定性設計規則及製造公差的第一級封裝上,插入損耗、反射和其他非線性損傷顯著減少

-

減少交換器上高速信號路徑的端口到端口變化,這增加了 DSP 信號處理、主機和模組均衡、主機和模組韌體以及連接優化算法的開銷和複雜性。所有可插拔模組解決方案和主機 SerDes 都必須設計為適應每端口性能的這種變化,這導致複雜性和故障點

-

移除光連接配置中的「人為」因素。CPO 交換器或光引擎在工廠完全組裝和測試為「已知良好」,不需要大量的現場操作來配置交換器中的光學設備,這可能導致安裝變化、損壞、污染以及系統和光學模組之間的兼容性問題

第三部分:將 CPO 推向市場與部署挑戰

CPO 光引擎製造考慮與上市

CPO 尚未以與大規模採用相稱的數量製造。Broadcom 是唯一一家已經出貨生產系統的供應商,通過其 Bailly 和 Humboldt 交換器,但現在 Nvidia 也加入戰局。這些產品出貨量非常低。CPO 引入了許多新的製造流程和重大的可製造性挑戰。可以理解的是,鑑於供應鏈的不成熟和缺乏可靠性數據,客戶也不願意冒險採用這項技術。

為了讓 CPO 獲得牽引力,行業領導者必須投資出貨這些產品,推動供應鏈開發可擴展的製造和測試流程。Nvidia 正在帶頭衝鋒,他們的意圖是讓供應鏈準備就緒,識別和解決問題,並為我們認為將是「殺手級」應用的資料中心運營商做準備:Scale-up 網路。

主機和光引擎封裝

顧名思義,「共封裝光學」從根本上是一個封裝和組裝的挑戰。

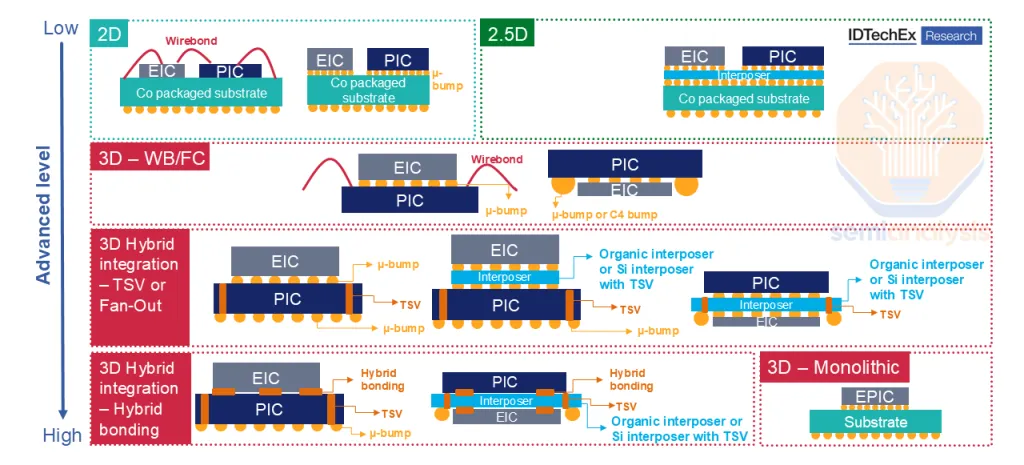

光引擎同時具有光學和電子元件。光電探測器和調變器是包含在「PIC」(光子積體電路)中的光學元件。驅動器和跨阻放大器是包含在「EIC」(電子積體電路)中的電子電路。PIC 和 EIC 需要整合才能使 OE 運作。存在多種封裝方法來完成這種 PIC-EIC 整合。

來源:ID TechEx

來源:ID TechEx

單片整合是最優雅的方法,在寄生效應、延遲和功率方面表現最佳。這是 Ayar Labs 第二代 TeraPHY 晶片所採用的方法。然而,單片製程在約 35nm 以下的幾何尺寸處停止,因為光子製程無法像傳統 CMOS 那樣擴展。這限制了 EIC 的能力,使單片整合成為擴展的破局者。

異質整合正在成為主流方法,涉及使用 SiPho 製程製造 PIC,並通過先進封裝將其與 CMOS 晶圓的 EIC 整合。3D 整合提供最佳的頻寬和能效。

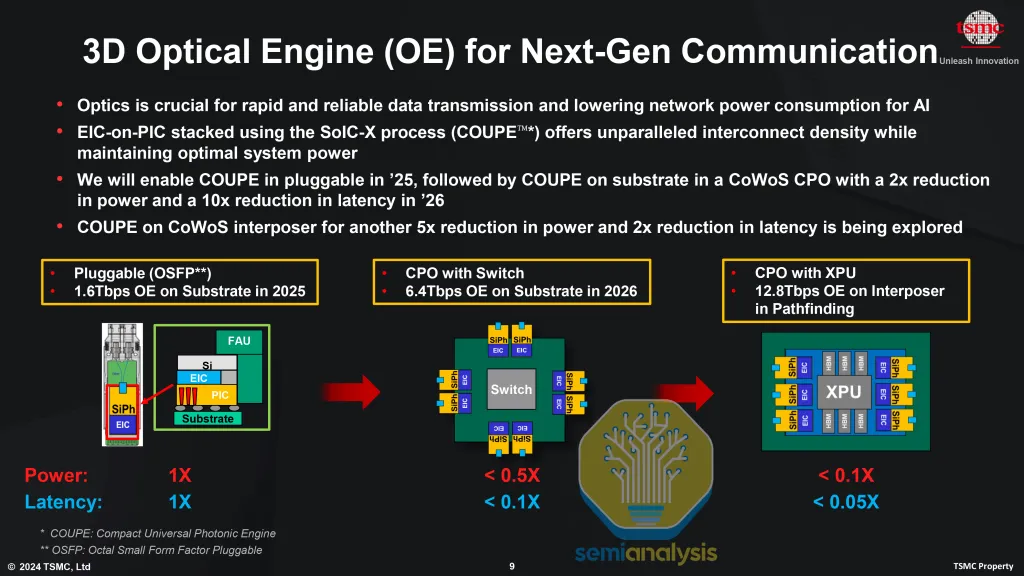

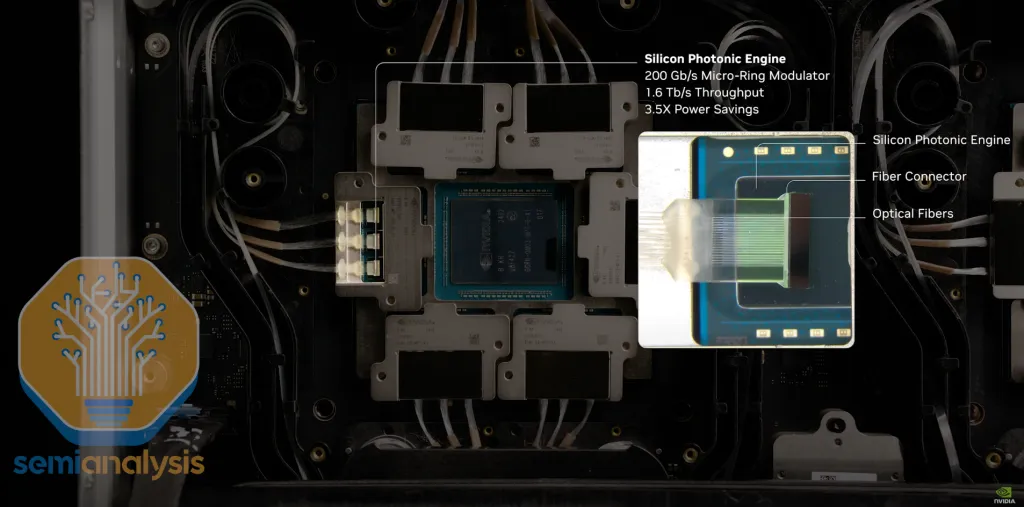

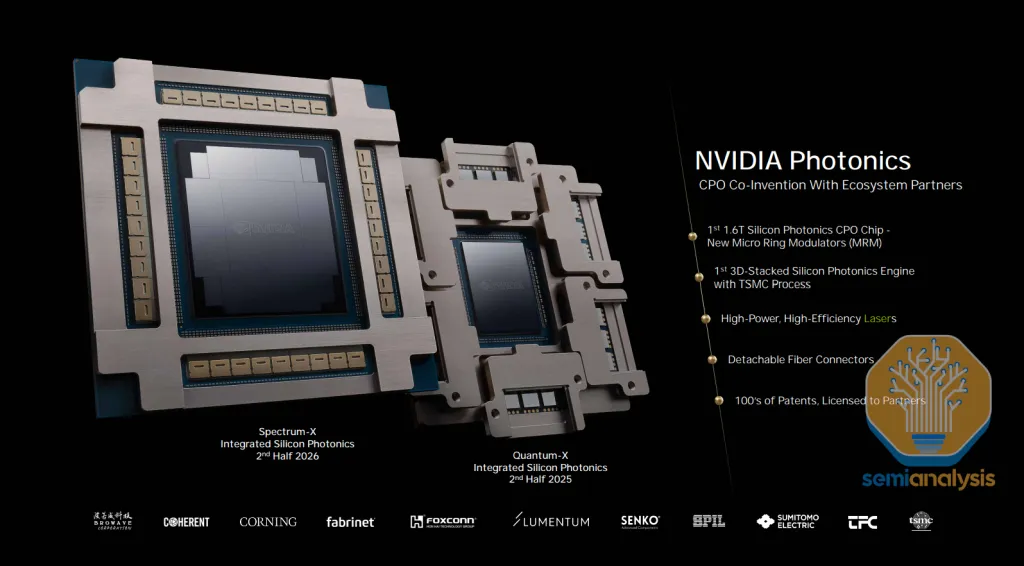

TSMC COUPE 正在成為首選的整合方案

TSMC 正在作為下一代 OE 的首選晶圓代工合作夥伴快速前進。第一批大規模生產的 CPO 端點產品正以「COUPE」(Compact Universal Photonic Engine 的縮寫)的名義推出。這包括 EIC 和 PIC 的製造,以及在 TSMC COUPE 解決方案下的異質整合。

Nvidia 在 GTC 2025 上自豪地展示了他們的 COUPE 光引擎,這將是第一批出貨的 COUPE 產品。Broadcom 也在為其未來路線圖採用 COUPE。如前所述,之前依賴 GlobalFoundries Fotonix 平台進行單片光引擎的 Ayar Labs,現在也將 COUPE 納入其路線圖。

來源:TSMC

來源:TSMC

製程節點:

- EIC:在 N7 節點製造,整合高速光學調變器驅動器和 TIA

- PIC:在 SOI N65 節點製造

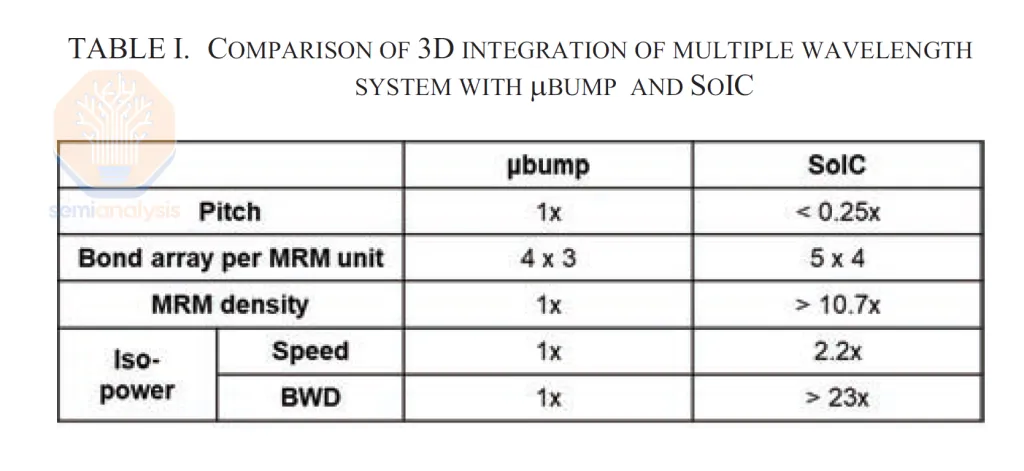

SoIC 鍵合:TSMC 的 SoIC 是一種無凸塊介面,提供不使用單片的情況下最短的跡線長度。如下所示,在等功率下,基於 SoIC 的 OE 提供的頻寬密度是使用凸塊整合的 OE 的 23 倍以上。

來源:TSMC

來源:TSMC

產品路線圖:第一代 COUPE 將是基板上的光引擎,最終目標是能夠將 OE 放在中介層上。中介層提供更高的 I/O 密度,因此能夠在 OE 和 ASIC PHY 之間實現更大的頻寬,每個 OE 可能具有高達 12.8Tbit/s 的頻寬,轉化為約 4 Tbit/s/mm。

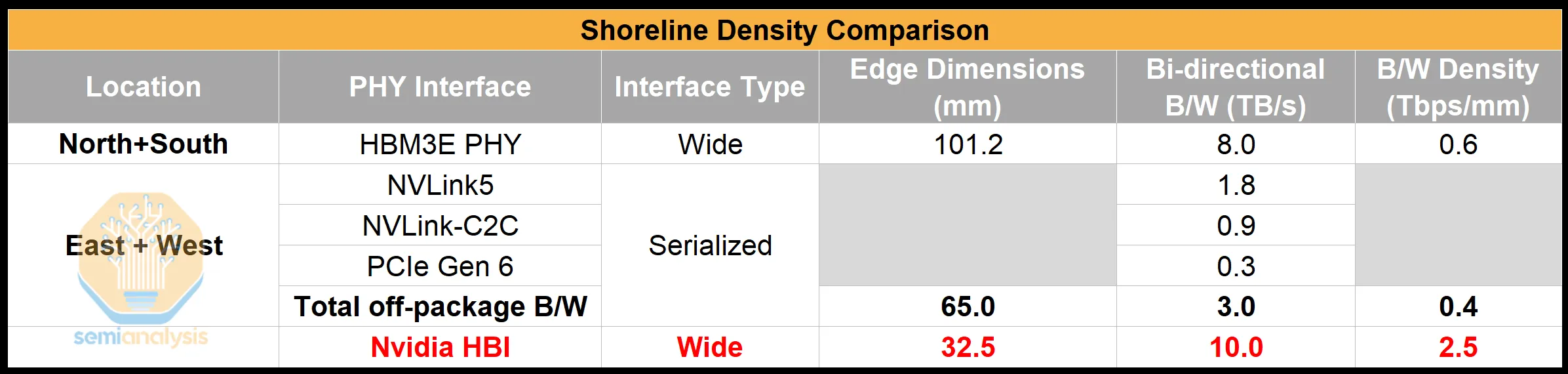

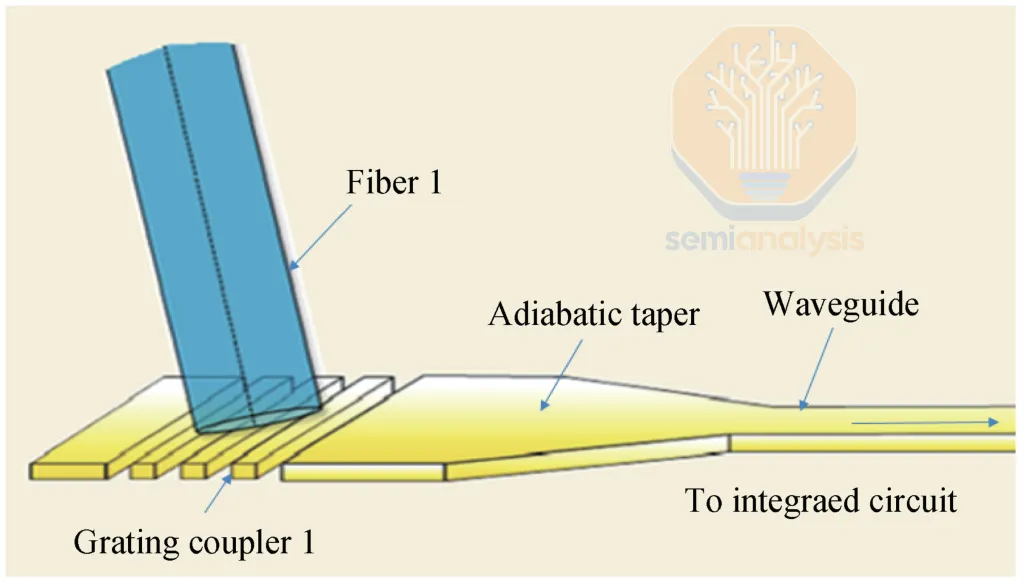

FAU 與光纖耦合

光纖從 OE 出來用於數據傳輸。一個光學通道由兩根光纖或一對光纖組成(發送加接收)。光纖耦合——將光纖與晶片上的波導精確對準以實現平滑高效的光傳輸——是 CPO 中的關鍵和具有挑戰性的步驟。

兩種主要耦合方式:

| 方式 | 優點 | 缺點 |

|---|---|---|

| 邊緣耦合 (EC) | 低耦合損耗、寬波長範圍、偏振不敏感 | 製造複雜、光纖密度受限(1D 結構)、不兼容裸晶堆疊 |

| 光柵耦合 (GC) | 可實現多行光纖(2D 密度)、更小佔地面積、製造更簡單 | 有限波長範圍、高偏振敏感性、較高光學損耗 |

Nvidia 和 TSMC 都明確偏好光柵耦合,這在 COUPE 平台中得到支持。

來源:Journal of Semiconductors

來源:Journal of Semiconductors

雷射類型與波長分割多工 (WDM)

將雷射整合到 CPO 中有兩種主要方式:

-

晶片上雷射:將雷射和調變器整合在同一光子晶片上

- 缺點:雷射是系統中最容易故障的組件之一;對熱敏感;功率輸出通常不夠高

-

外部光源 (ELS):行業共識方案

- 雷射在單獨的模組中,通過光纖連接到光引擎

- 通常採用可插拔形式如 OSFP

- 簡化了雷射故障時的現場服務

波長分割多工 (WDM) 是指多個不同波長(或 lambda)的光通過同一根光纖傳輸:

- CWDM(粗波長分割多工):較少通道,間隔較遠(通常 20nm)

- DWDM(密集波長分割多工):更多通道,間隔非常緊密(通常 <1nm),可容納 40、80 甚至超過 100 個通道

調變器類型深度分析

當雷射進入 PIC 時,它們經歷調變階段,將電信號編碼到雷射波長中。三種主要調變器類型:

1. 馬赫-曾德調變器 (MZM)

MZM 通過將連續波光信號分成兩個波導臂來編碼數據,這兩個臂的折射率通過施加的電壓改變。當臂重新組合時,它們的干涉圖案調製信號的強度或相位。

優點:

- 最容易實現,熱敏感性低

- 高線性度支持先進調變格式如 PAM4

- 可實現更高的每通道頻寬:200G 已證明可行,400G 被認為可能

缺點:

- 大尺寸(毫米級,約 12,000µm²)

- 高功耗

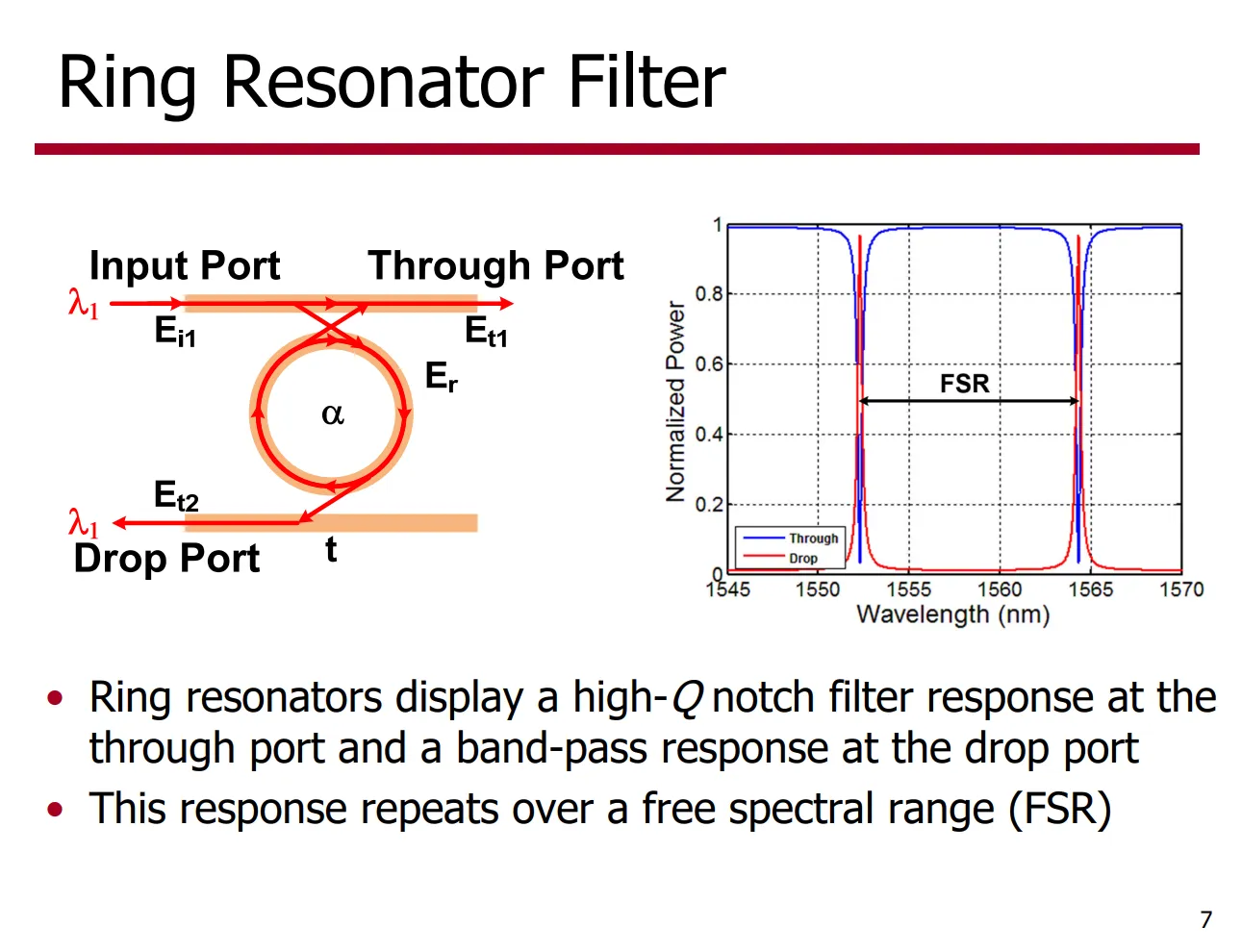

2. 微環調變器 (MRM)

MRM 使用緊湊的環形波導耦合到一個或多個直波導。電信號改變環的折射率,移動其共振波長。

優點:

- 極其緊湊(數十微米級,25-225µm²)

- 非常適合 WDM 應用(包括 8 或 16 波長的 DWDM)

- 高能效(每比特功率更低)

缺點:

- 比 MZM 和 EAM 對溫度敏感 10-100 倍

- 非線性,複雜化高階調變如 PAM4/6/8

Nvidia 明確偏好 MRM,他們聲稱是第一個在 CPO 系統中設計和使用 MRM 的公司。

3. 電吸收調變器 (EAM)

EAM 通過根據施加的電壓改變其吸收光的能力來調製信號。

優點:

- 比 MRM 具有更好的熱穩定性(可容忍高達 35°C 的瞬時溫度變化)

- 比 MZM 尺寸更小、功耗更低(約 250µm²)

缺點:

- GeSi 基 EAM 被認為可靠性不如 MRM 和 MZM

- GeSi 調變器的帶邊自然在 C 波段,難以用於 O 波段

Celestial AI 是主要使用 EAM 進行調變的少數公司之一。

來源:Sam Palermo, Texas A&M University

來源:Sam Palermo, Texas A&M University

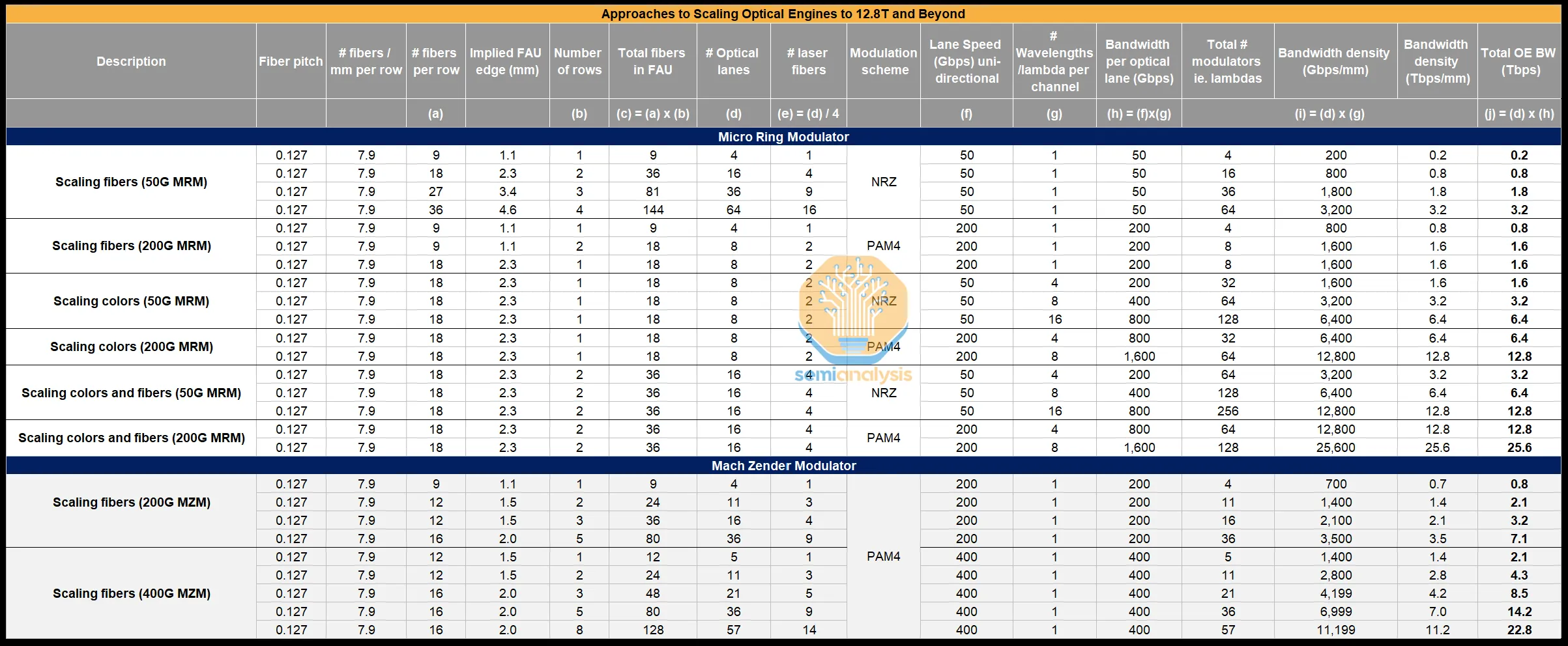

頻寬擴展的關鍵方法

擴展共封裝光引擎頻寬的關鍵方法:

| 方法 | 說明 | 挑戰 |

|---|---|---|

| 更多光纖對 | 目前最小間距 127µm(每毫米最多 8 根光纖),業界正朝 80µm 間距發展 | 對準光纖良率問題 |

| 每通道速度 | 波特率(目前 100Gbaud,推向 200Gbaud)+ 調變(PAM4 → PAM6/8) | 調變器切換頻率要求更高 |

| WDM | 每根光纖承載多個波長(目前商用 8-16 lambda) | 需要可靠的多波長雷射光源 |

來源:SemiAnalysis

來源:SemiAnalysis

第四部分:當今和未來的 CPO 產品

Nvidia CPO

在 GTC 2025 上,Nvidia 推出了三款不同的 CPO scale-out 交換器:

來源:SemiAnalysis

來源:SemiAnalysis

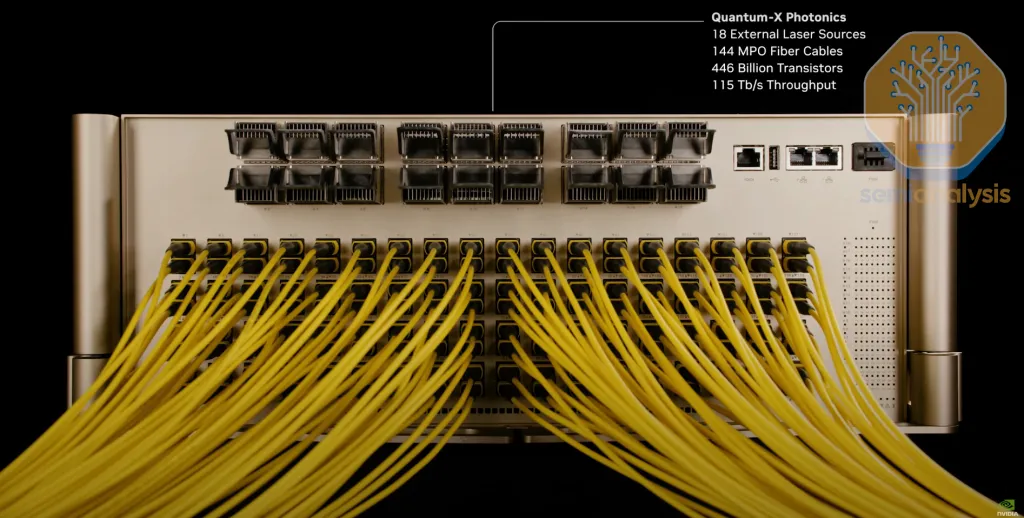

Quantum-X Photonics

Quantum X800-Q3450 將於 2025 年下半年上市,是第一款進入市場的 CPO 交換器:

- 144 個物理 MPO 端口

- 144 個 800G 邏輯端口或 72 個 1.6T 邏輯端口

- 總頻寬 115.2T

- 使用四個 Quantum-X800 ASIC 晶片的多平面配置

來源:Nvidia

來源:Nvidia

每個 ASIC 周圍有六個可拆卸的光學子組件,每個子組件包含三個光引擎。每個光引擎提供 1.6 Tbit/s 頻寬,每個 ASIC 總共 18 個光引擎,總光學頻寬 28.8 Tbit/s。

關鍵技術突破:Nvidia 和 TSMC 可以在生產中出貨 200G MRM。這匹配了今天最快的 MZM,並證明了行業認為 MRM 僅限於 NRZ 調變的觀念是錯誤的。

來源:Nvidia

來源:Nvidia

Spectrum-X Photonics

Spectrum-X Photonics 預計 2026 年下半年發布:

- Spectrum 6810:102.4T 總頻寬

- Spectrum 6800:409.6T 總頻寬(使用四個 Spectrum-6 MCM)

每個 Spectrum-X photonics MCM 交換器封裝將有 36 個光引擎,使用 Nvidia 的第二代 3.2T 頻寬光引擎。

來源:Nvidia

來源:Nvidia

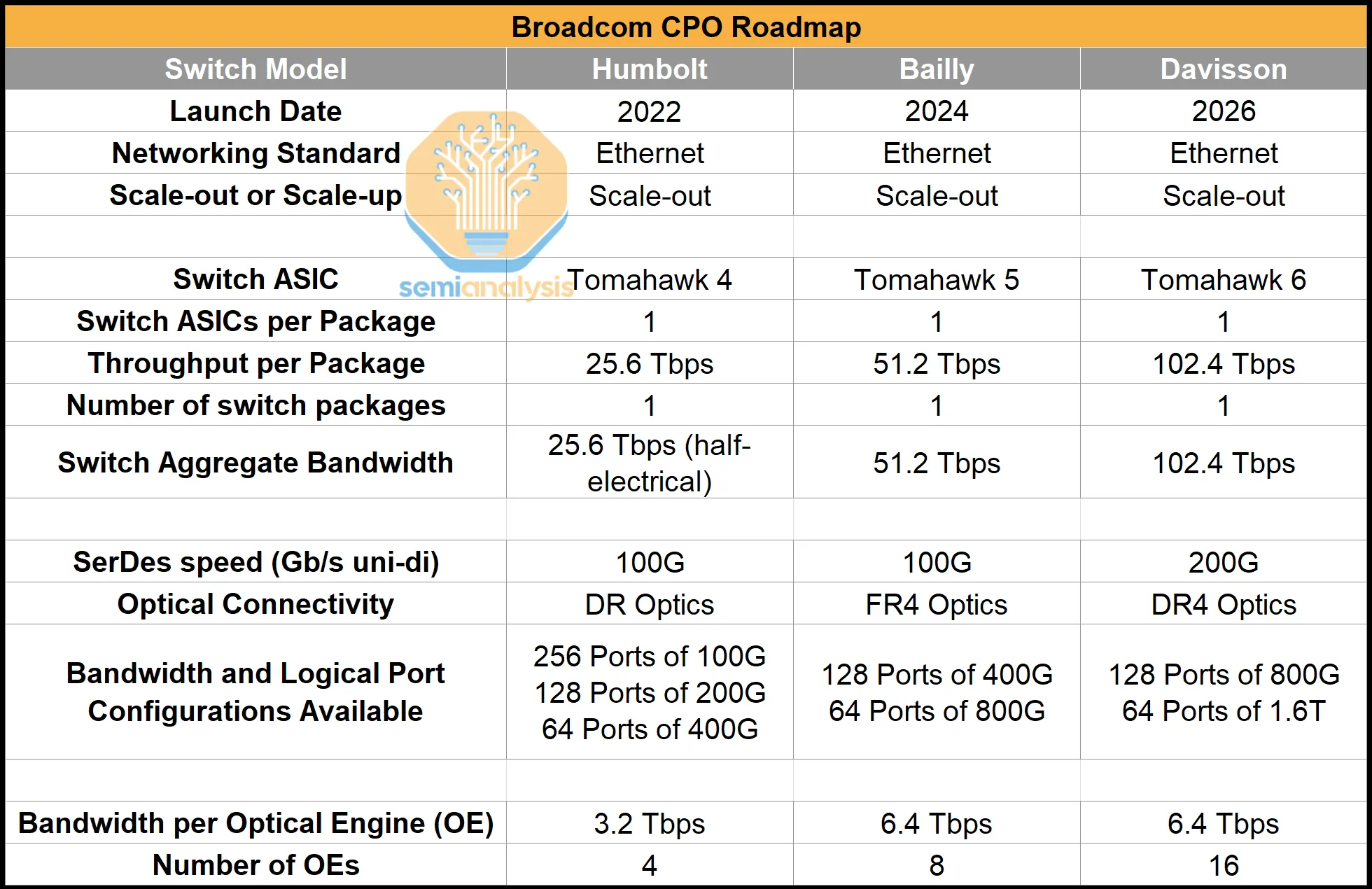

Broadcom CPO 交換器組合

來源:SemiAnalysis

來源:SemiAnalysis

Broadcom 是最早提供真正 CPO 系統的公司之一:

| 代次 | 產品名稱 | 頻寬 | 特點 |

|---|---|---|---|

| 第一代 | Humboldt | 25.6T | 混合銅線和光學,4 個 3.2T OE |

| 第二代 | Bailly | 51.2T | 全光學 I/O,8 個 6.4T OE,7nm CMOS EIC |

| 第三代 | Davisson (TH6) | 102.4T | 16 個 6.4T OE,TSMC N3 製程 |

重要趨勢:Broadcom 未來幾代 CPO 端點也在轉向 TSMC COUPE 平台,從邊緣耦合和 MZM 轉向光柵耦合和 MRM——這是其現有方法的重大變化。

CPO 專注公司

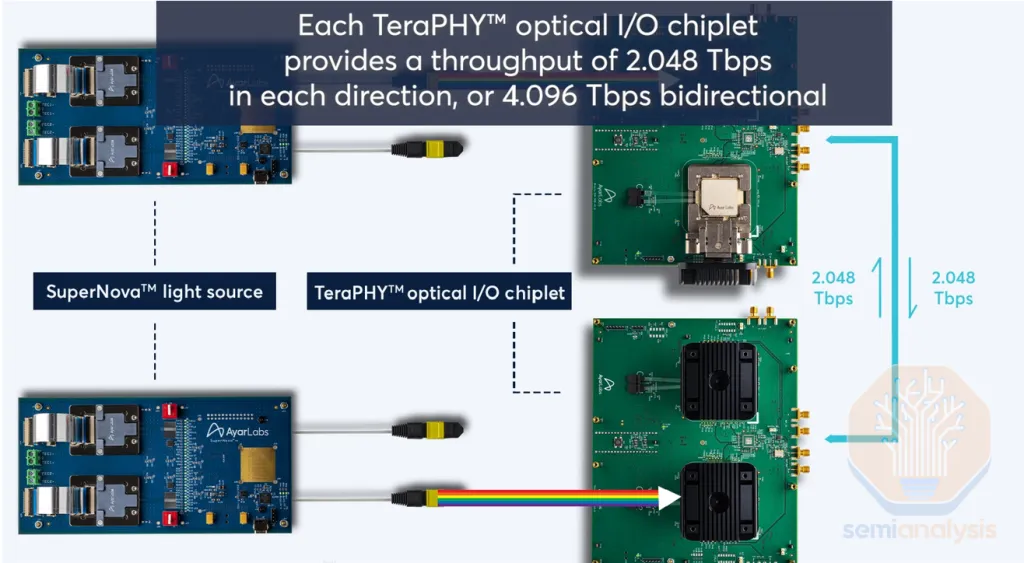

Ayar Labs

- 產品:TeraPHY 光引擎晶片

- 第二代 Eagle:4 Tbit/s 單向頻寬,使用 MRM,8 個 512G I/O 端口

- 第三代:轉向 TSMC COUPE,每個 OE 13.5+ Tbit/s

- 合作夥伴:GlobalFoundries、Intel Capital、Nvidia、AMD、TSMC

來源:Ayar Labs

來源:Ayar Labs

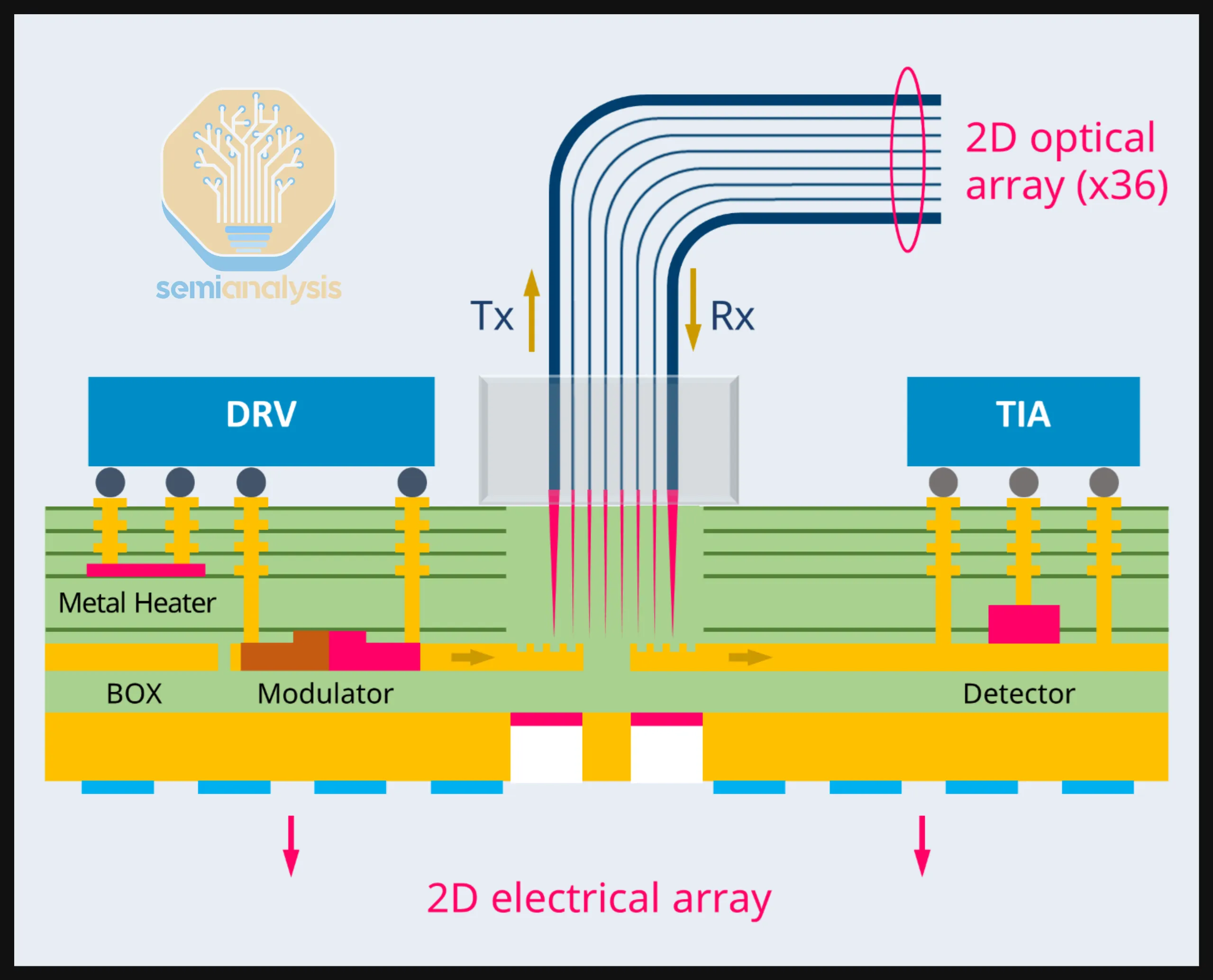

Nubis(已被 Ciena 收購)

- 產品:Vesta 100 1.6T NPX 光引擎

- 特點:強調互操作性,使用 MZM

- 獨特創新:2D 光纖陣列,36 根光纖連接到 PIC

- 差異化:使用玻璃塊(FAU)作為光纖支架,雷射鑽孔確保精確定位

來源:Nubis

來源:Nubis

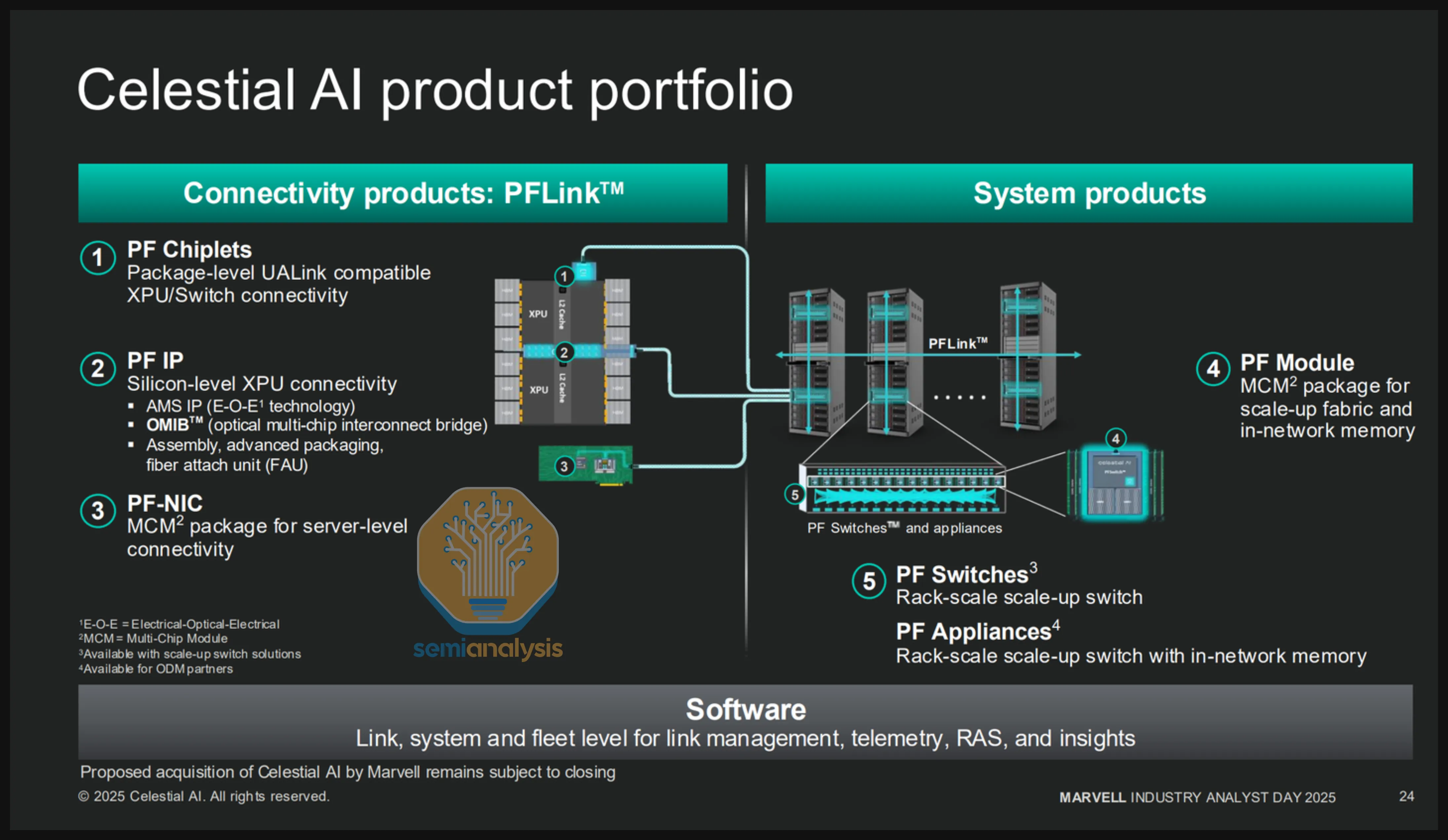

Celestial AI(已被 Marvell 收購)

- 產品:Photonic Fabric™ (PF) 系列

- 技術特點:使用 EAM 調變器,將光子器件構建到中介層中

- Photonic Fabric™ Chiplets:TSMC 5nm 晶片,第一代 16 Tbit/s,第二代 64 Tbit/s

- OMIB™(光學多晶片互連橋):在中介層嵌入光子技術的 CoWoS-L/EMIB 風格封裝

重要里程碑:Marvell 預計 Celestial AI 到 2028 年底收入運行率達 10 億美元,主要由 Amazon Trainium 4 驅動。

來源:Celestial AI

來源:Celestial AI

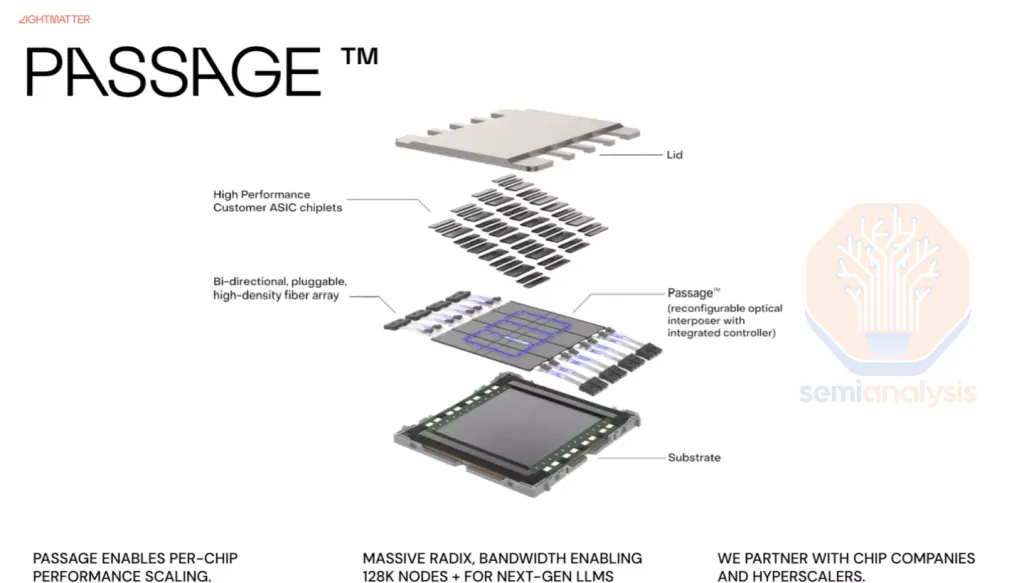

Lightmatter

- 近期產品:NPO 光引擎(2026/2027)

- 旗艦產品:Passage™ M1000 3D Photonic Superchip

- 4,000 mm² 光學中介層

- 放置在主機計算引擎下方

- 1,024 個緊湊型低功耗 SerDes

- 總 I/O 頻寬 114 Tbit/s

- GUIDE 雷射:業界首款 VLSP 雷射,可支持高達 50 Tbit/s 頻寬

來源:Lightmatter

來源:Lightmatter

其他 CPO 公司

| 公司 | 主要產品/技術 | 特點 |

|---|---|---|

| Xscape Photonics | ChromX 可編程雷射 | 4-128 波長,單光纖承載所有波長 |

| Ranovus | Odin 光引擎 | 專注 Ethernet 標準互操作性,MRM |

| Scintil | LEAF Light PSoC | 晶圓級 III-V 雷射整合,8-16 波長 DWDM |

第五部分:Nvidia CPO 供應鏈

Nvidia CPO 生態系統的關鍵供應商:

| 組件 | 功能 | 主要供應商 |

|---|---|---|

| 雷射光源 | 產生光信號 | Lumentum、Ayar Labs、Innolume、Xscape |

| ELS 模組 | 外部雷射光源封裝 | 多家 |

| FAU | 光纖附著單元 | - |

| FAU 對準工具 | 光纖對準自動化 | Ficontec |

| Shuffle Box | 光纖路由管理 | - |

| MPO 連接器 | 多光纖連接 | - |

| MT 套圈 | 光纖端面對準 | - |

| 光纖 | 數據傳輸介質 | Sumitomo Electric |

| E/O 測試 | 電光測試 | - |

關鍵要點總結

CPO 的核心價值主張

- 功耗節省:相比 DSP 收發器可減少 65-73% 的每 800G 頻寬功耗

- 頻寬密度:通過消除長距離 SerDes 需求,實現更高的短線頻寬密度

- 可靠性提升:減少組件數量和信號路徑變異性,Meta 測試顯示 CPO 的 MTBF 約為收發器的 5 倍

市場時機

- Scale-out CPO:近期採用有限,TCO 優勢不夠顯著(僅 3-7% 總成本節省)

- Scale-up CPO:殺手級應用,預計 2027-2028 年開始大規模部署

- 關鍵里程碑:Nvidia 的 Feynman 代(2028 後)預計是 CPO 大規模注入的焦點

技術演進路徑

DSP 收發器 → LPO → NPO → CPO(基板) → CPO(中介層)

↓ ↓

高功耗 最低功耗

高延遲 最低延遲供應鏈關鍵玩家

| 領域 | 主要公司 |

|---|---|

| CPO 解決方案 | Ayar Labs, Nubis, Celestial AI, Lightmatter |

| 交換器整合 | Nvidia, Broadcom |

| 封裝技術 | TSMC (COUPE) |

| 雷射光源 | II-VI/Coherent, Lumentum |

原文來源:SemiAnalysis - Co-Packaged Optics (CPO) Book

翻譯說明:本文為 SemiAnalysis 深度報告的完整中文翻譯版本,涵蓋全部五個章節。技術術語盡量保留英文原文以便對照。圖片已下載至本地存儲。